Viele Organisationen führen Web Scraping durch, um Informationen aus dem Internet zu extrahieren und sie zu ordnen und zu analysieren, um ihre Geschäftsprozesse voranzutreiben.

Wenn Sie jedoch weiterhin manuell Web Scraping durchführen, Hunderte von Websites besuchen und kontinuierlich Daten extrahieren, kann dies zu einer schmerzhaften (und riskanten) Aufgabe werden.

Sie könnten mit geografischen Beschränkungen konfrontiert sein oder von diesen Websites ausgeschlossen werden, da jeder seine Daten schützen möchte.

Daher kann die Verwendung eines Tools wie eines Datensammlers eine gute Möglichkeit sein, dies zu tun.

Ein guter Datensammler hilft Ihnen dabei, Daten schnell, sicher und zuverlässig zu kratzen. So können Sie Qualitätsdaten verwenden, um Vorhersagen zu treffen, Prozesse zu rationalisieren und Ihren Betrieb zu gestalten.

In diesem Artikel werde ich erläutern, was Datenerfassung bedeutet, welche Arten und Techniken sie verwendet, und Ihnen dann einige der besten Datenerfassungstools vorstellen.

Lasst uns beginnen!

Inhaltsverzeichnis

Was ist Datenerhebung?

Die Datenerhebung ist ein Prozess des Sammelns und Analysierens bestimmter Informationen, um bestimmte Fragen zu beantworten und die Ergebnisse zu bewerten. Es zielt darauf ab, alles über ein bestimmtes Thema zu finden. Nach dem Sammeln von Daten werden diese dann einem Hypothesentestprozess unterzogen, um eine bestimmte Sache oder ein bestimmtes Ereignis zu erklären.

Die Datenerhebung könnte aus einer Reihe von Gründen erfolgen, beispielsweise zur Vorhersage zukünftiger Trends und Wahrscheinlichkeiten.

Und das Tool, das bei der Datenerfassung hilft, ist ein Datensammler oder eine Datenerfassungssoftware. Es verfügt über erstaunliche Funktionen und Vorteile, die den gesamten Datenerfassungsprozess unterstützen.

Arten der Datenerhebung

Die Datenerhebung fällt unter diese beiden Hauptkategorien – primäre und sekundäre Datenerhebung.

Primäre Datenerhebung

Die Primärdatenerfassung umfasst den Prozess der Erfassung von Rohdaten an der Quelle oder von Originaldaten für einen bestimmten Zweck, sei es Web Scraping, Forschung oder ein anderes Ziel. Es ist weiter in zwei Arten unterteilt:

- Quantitative Datenerhebung: Es gibt viele Methoden, die bei der quantitativen Datenerhebung eingesetzt werden, wie z. B. die Datenerhebung per Telefon, E-Mail, online oder persönlich. Diese Methoden erfordern eine mathematische Berechnung, um sie zu verstehen, und werden in Zahlen dargestellt. Beispiele für diese Methoden könnten Fragebögen mit geschlossenen Fragen, Regression, Median, Mittelwert und Modus sein.

- Qualitative Forschung: Dies ist eine Datenerhebungsmethode, die keine mathematischen Berechnungen oder Zahlen beinhaltet. Es basiert auf Elementen, die nicht quantifizierbar sind, wie z. B. den Emotionen oder Gefühlen des Forschers. Solche Techniken könnten offene Fragebögen, Tiefeninterviews, Webumfragen und Daten umfassen, die von Online-Communities, Online-Foren, Gruppen usw. gesammelt wurden.

Sekundäre Datenerhebung

Bei der sekundären Datenerfassung werden Daten aus zweiter Hand erfasst, die von jemandem erfasst werden, der nicht der ursprüngliche Benutzer ist. Das bedeutet, dass Sie in diesem Prozess vorhandene Daten aus veröffentlichten Büchern, Online-Portalen, Zeitschriften usw. sammeln. Dieser Prozess ist einfacher und kostengünstiger.

Bei dieser Art der Datenerfassung können Sie alle Informationen zuvor von jemandem analysieren lassen. Die sekundäre Datenerhebung umfasst zwei Arten von Daten:

- Veröffentlichte Daten: Dies können Regierungsveröffentlichungen, ein Podcast, Websites, öffentliche Aufzeichnungen, statistische und historische Dokumente, Fachzeitschriften, technische Unterlagen, Geschäftsdokumente usw. sein.

- Unveröffentlichte Daten: Dies können Briefe, Tagebücher und unveröffentlichte Biografien sein.

Die Wahl zwischen primärer und sekundärer Datenerhebung hängt also von Ihrem spezifischen Forschungsgebiet, Nischentyp, Gelegenheit, Projektziel usw. ab. Wählen Sie diejenige aus, die für Sie am besten geeignet ist, um intelligente Entscheidungen zu treffen.

Vorteile des Datenerfassungstools

Wie oben erläutert, ist ein Datenerfassungstool oder Datensammler eine Software, die für die Datenerfassung durch Papierfragebögen, Umfragen, Fallstudien, Forschung, Beobachtung usw. verwendet wird.

Da eine Studie, Analyse, Recherche oder Web-Scraping zu verschiedenen Zwecken durchgeführt wird, müssen Sie sicherstellen, dass echte, hochwertige Daten gesammelt werden, um zu glaubwürdigen Lösungen für ein bestimmtes Problem zu führen. Hier ist der Einsatz eines guten Datenerfassungstools erforderlich. Es bietet zahlreiche Funktionen und Vorteile, um Ihren Datenerfassungsprozess mühelos und zufriedenstellend zu gestalten.

Hier sind einige der Vorteile der Verwendung eines Datenerfassungstools.

Genauigkeit

Moderne Datenerfassungstools verfügen über eine riesige Bibliothek zuverlässiger Informationen. Diese Datenbank wird auch regelmäßig aktualisiert, um Ihnen frische, aktuelle Informationen zu bieten, die nicht nur für Ihre Organisation relevant, sondern auch genau sind.

Schneller

Datensammler helfen, den Prozess des Web Scraping oder der Recherche zu beschleunigen. Der Grund dafür ist, dass es mit einer Datenbank mit umfangreichen, nützlichen Informationen verbunden ist, auf die Sie von überall und jederzeit mit wenigen Klicks zugreifen können. So können Sie Ihre Recherchen unterwegs, im Büro oder zu Hause durchführen. Es beschleunigt den gesamten Datenerfassungsprozess und spart Ihnen viel Zeit.

Weniger Fehler

Während Sie Daten für Ihren Anwendungsfall manuell sammeln können, kann dies menschliche Fehler beinhalten. Die Verwendung eines speziellen Datenerfassungstools liefert Ihnen jedoch genaue und konsistente Informationen, um Ihre Geschäftsprozesse und -ziele voranzutreiben. Es wird Ihnen auch dabei helfen, die Integrität Ihrer Forschung, Ihres Studiums oder Ihres Web-Scrapings zu wahren.

Bessere Ergebnisse

Da Sie mithilfe eines Datenerfassungstools für den beabsichtigten Zweck vollständige, zuverlässige, fehlerfreie und relevante Daten erhalten, erzielen Sie bessere Ergebnisse, anstatt Fehler zu machen, die zu weiteren Problemen führen können. Die Verwendung präziser, relevanter, vollständiger und zuverlässiger Daten hilft Ihnen, bessere Geschäftsentscheidungen zu treffen und Vorhersagen zu treffen.

Datenerfassung vs. traditionelle Web-Scraping-Lösungen

Herkömmliche Web Scraper können vielseitig sein, aber sie können zeitaufwändig sein und mehr Aufwand erfordern. Es ist offensichtlich, besonders wenn Sie es mit großen Datenmengen zu tun haben. Da das Internet Billionen von Daten enthält, die aus so vielen Umfragen, Foren, Online-Sites, Berichten usw. bestehen, ist das Extrahieren relevanter, nützlicher Informationen eine Herausforderung.

Mit einem fortschrittlichen Datenerfassungstool wie Bright Data Collector können Sie Daten jedoch schnell, einfach und auf etwas aufregendere Weise erfassen.

Bei so vielen im Internet verfügbaren Datensammlern fällt es vielen schwer, sich für einen zu entscheiden. So wählen Sie das richtige Datenerfassungstool für Ihre Anforderungen aus.

Wie wählt man das richtige Datenerfassungstool aus?

Achten Sie bei der Auswahl eines Datenerfassungstools auf diese Aspekte:

- Nützliche Funktionen: Wählen Sie einen Datensammler mit nützlichen Funktionen für Ihre Anwendungsfälle. Schätzen Sie Ihre Anforderungen ein und wählen Sie dann das Tool aus, das Ihnen die Funktionen bietet, die Sie tatsächlich verwenden werden. Es muss auch mit anderen Tools integriert werden, um die Arbeit mit nur einem Tool zu erleichtern.

- Benutzerfreundlich: Wenn Sie das Beste aus einem Datensammler herausholen möchten, suchen Sie nach einem, der einfach zu verwenden ist. Es muss eine einfache, aber leistungsstarke Benutzeroberfläche, einfache Navigation und mühelose Zugänglichkeit haben.

- Erschwinglichkeit: Investieren Sie in ein Tool, das unter Ihr Budget fällt, aber über eine Reihe nützlicher Funktionen verfügt. Es geht darum, die Balance zu finden. Suchen Sie auch nach einer kostenlosen Testversion, um zu testen, wie es für Sie funktioniert.

Wenn Sie also nach einem guten Datenerfassungstool suchen, ist Bright Data Collector eine gute Option. Informieren Sie sich über dieses Tool, um zu entscheiden, ob es für Sie geeignet ist.

Wie kann Bright Data helfen?

Bright Data Collector ist eine der besten Plattformen für die Datenerfassung und das Web Scraping. Es kratzt Daten aus dem Internet in großem Maßstab ohne Infrastrukturanforderungen. Es kann sofort öffentlich verfügbare Daten von jeder Website extrahieren, sodass Sie Ihre Web-Scraping- oder Rechercheanforderungen erfüllen können.

Sie können wählen, ob Sie Webdaten entweder stapelweise oder in Echtzeit auslesen möchten. Bewerten Sie einfach Ihre Anforderungen und verwenden Sie Bright Data Collector, um Ihre Anforderungen zu erfüllen.

Bright Data Collector: Hauptmerkmale

Einige Hauptfunktionen von Bright Data Collector sind:

Keine Code-Plattform

Vereinfachen Sie Ihre Web-Scraping-Bemühungen mit der No-Code-Plattform von Bright Data Collector. Dies bedeutet, dass Sie sich nicht mit Codierung befassen müssen, um diese Lösung zu verwenden und Scraping durchzuführen.

Früher war dieser Prozess kompliziert, sodass Programmierer das Tool korrekt konfigurieren mussten. Es erforderte auch Datenerfassungsspezialisten für Web Data Scraping und Proxy-Management.

Daher ist Bright Data Collector mit einer No-Code-Plattform für alle einfach zu verwenden, unabhängig davon, ob Sie Programmierer oder Experte für Datenextraktion sind oder nicht. Dadurch sparen Sie viele Stunden, Ressourcen und Zeit, die Sie anderen wichtigen Aufgaben widmen können.

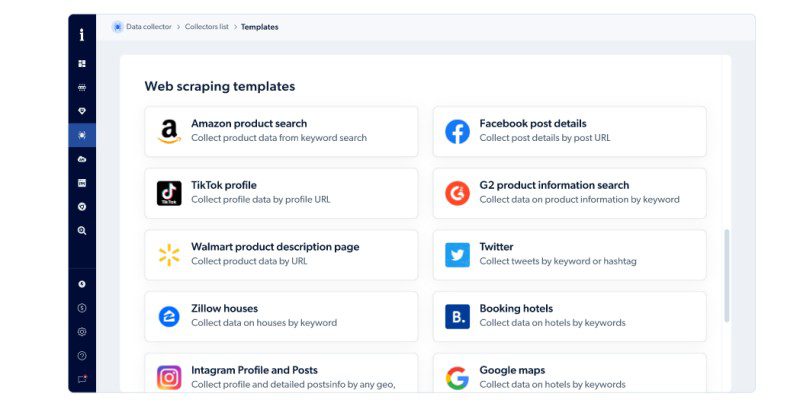

Vorgefertigte Codierungsvorlagen und Funktionen

Sie erhalten vorgefertigte Codierungsvorlagen und Funktionen in der gehosteten Lösung von Bright Data. Dies erleichtert die Erstellung eines Web-Scraping-Tools in großem Maßstab. Auf diese Weise können Sie mithilfe der JavaScript-IDE öffentlich verfügbare Webdaten schneller in Echtzeit erfassen. Sie können ihre API auch mit einem Workflow verbinden und von einem optimierten und reibungslosen Datenerfassungsprozess profitieren.

Bright Data Collector bietet Web-Scraping-Vorlagen für Amazon-Produktsuchen, Zillow-Häuser, Instagram-Profile und -Posts, Google Maps, Twitter, Facebook-Postdetails, Walmart-Produktbeschreibungsseiten und mehr.

Nahtlose Strukturierung

Bright Data Collector verwendet KI-Algorithmen, um die unstrukturierten Daten einer Website vor der Bereitstellung nahtlos abzugleichen, zu bereinigen, zu verarbeiten, zu strukturieren und zu synthetisieren. So könnten die gewonnenen Datensätze schneller für die Analyse bereit sein.

Automatisierte Flexibilität

Seitenstrukturen auf Websites ändern sich ständig. Das Scrapen von Daten von solchen Websites kann daher schwierig und verwirrend sein. Aber keine Sorge; Bright Data Collector bietet eine hervorragende Lösung für dieses Problem. Es kann sich schnell an die strukturellen Veränderungen von Websites anpassen und nützliche Daten extrahieren, um Ihren Analyseprozess voranzutreiben.

Skalierung auf Unternehmensniveau

Das Sammeln von Daten in großem Maßstab erfordert eine robuste Hardware- und Softwareinfrastruktur sowie Zeit und Ressourcen. Dies ist ein kostspieliges Geschäft und könnte ein mögliches Hindernis für Organisationen mit begrenzten Budgets darstellen.

Aber Bright Data Collector kann Ihnen hier helfen. Es sammelt genaue, nützliche Daten einfach und zuverlässig in großem Maßstab. Sie müssen nicht in kostspielige Hardware- oder Softwareinfrastruktur investieren und sparen so Geld.

Beachtung

Es ist wichtig, die geltenden Regeln und Vorschriften in Ihrer Region oder Ihrem Land einzuhalten. Es erspart Ihnen nicht nur Strafen, sondern trägt auch dazu bei, das Vertrauen Ihrer Kunden, Kunden und Mitarbeiter zu bewahren.

Bright Data Collector ist vollständig konform mit den Datenschutzbestimmungen, einschließlich GDPR, EU und CCPA. So können Sie unbesorgt Web Scraping betreiben. Dieser Versuch des Datenschutzes hilft Ihnen auch, Audits schnell zu bestehen.

Vielseitigkeit

Bright Data Collector hat Best Practices und umfassende Richtlinien zur Nutzung dieser Plattform bei gleichzeitiger Gewährleistung des Datenschutzes entwickelt. Aus diesem Grund vertrauen ihm nicht nur Unternehmen aller Formen und Größen, sondern auch Regierungen und Universitäten.

Robuste Proxy-Netzwerkinfrastruktur

Bright Data verfügt über eine patentierte und branchenführende Proxy-Netzwerkinfrastruktur. Und Data Collector baut auf dieser Infrastruktur auf. Daher werden Sie keine Schwierigkeiten haben, auf öffentliche Websites zuzugreifen. Es wird alle Hindernisse überwinden, wie z. B. geografische Beschränkungen, Zugänglichkeit usw. Sie können also Daten von überall extrahieren, die öffentlich verfügbar sind.

Funktioniert wie ein Geschäftspartner

Sie können entweder diese Self-Service-Plattform verwenden oder ihre Entwicklungsressourcen nutzen. Seine Entwickler, Produktmanager und Kundenbetreuer können Ihnen bei jedem Schritt helfen, Ihre Geschäftsprobleme zu lösen und Ihre Anforderungen zu erfüllen, damit Sie mehr Wachstum verzeichnen können.

Wie funktioniert Bright Data Collector?

Für die Verwendung von Bright Data Collector müssen Sie kein Programmierer oder Web-Scraping-Spezialist sein. Stattdessen können Sie diese Plattform einfach installieren und verwenden, ohne die erforderliche Hilfe zu benötigen.

Sie können damit in drei einfachen Schritten arbeiten:

Wählen Sie eine Vorlage

Wählen Sie entsprechend Ihrer Anforderung eine vorgefertigte Codevorlage aus den vorgegebenen Optionen aus. Sie haben auch die Möglichkeit, eine von Grund auf neu zu erstellen, anstatt vorgefertigte Vorlagen zu verwenden.

Wenn Sie beispielsweise nach Produktlisten bei Amazon suchen, möchten Sie möglicherweise die Vorlage für die Amazon-Produktsuche verwenden.

Anpassen

Der nächste Schritt ist das Anpassen oder Entwickeln Ihres beabsichtigten Web Scrapers mithilfe der vorgefertigten Scraping-Funktionen von Bright Data Collector.

Wenn Sie nicht wissen, wie man codiert, ist es in Ordnung. Diese No-Code-Lösung ist Ihre erste Wahl, um mit der verfügbaren Option einen Web Scraper von Grund auf neu zu erstellen. Wenn Sie jedoch wissen, wie man codiert, können Sie viel mehr als das tun. Sie können den Code bearbeiten, um den Schaber für Ihre Anforderungen besser geeignet zu machen.

Echtzeit oder Batch

Nachdem Sie den Web Scraper für Ihren spezifischen Anwendungsfall erstellt haben, wählen Sie aus, wann Sie die Daten erhalten möchten – in Stapeln oder in Echtzeit. Die Datenfrequenz hängt ganz von Ihren Bedürfnissen ab. Bewerten Sie also zuerst Ihre Bedürfnisse und wählen Sie dann eine Option aus, um mit dem nächsten Schritt fortzufahren.

Format und Lieferung

In diesem Schritt müssen Sie das Dateiformat auswählen, in dem Sie Daten abrufen möchten. Dies kann CSV, JSON, XLSX oder NDJSON sein.

Wählen Sie als Nächstes die Option aus, an die Sie die gesammelten Daten senden möchten. Sie erhalten diese Optionen – E-Mail, Webhook, API, Google Cloud, Amazon S3, MS Azure und SFTP.

Kundendienst

Wenn Sie irgendwo nicht weiterkommen, können Sie sich rund um die Uhr an den technischen Support von Bright Data wenden. Sie sind hilfsbereit und kompetent, um Ihre Probleme rund um die Uhr zu lösen.

Preise: Bright Data Collector

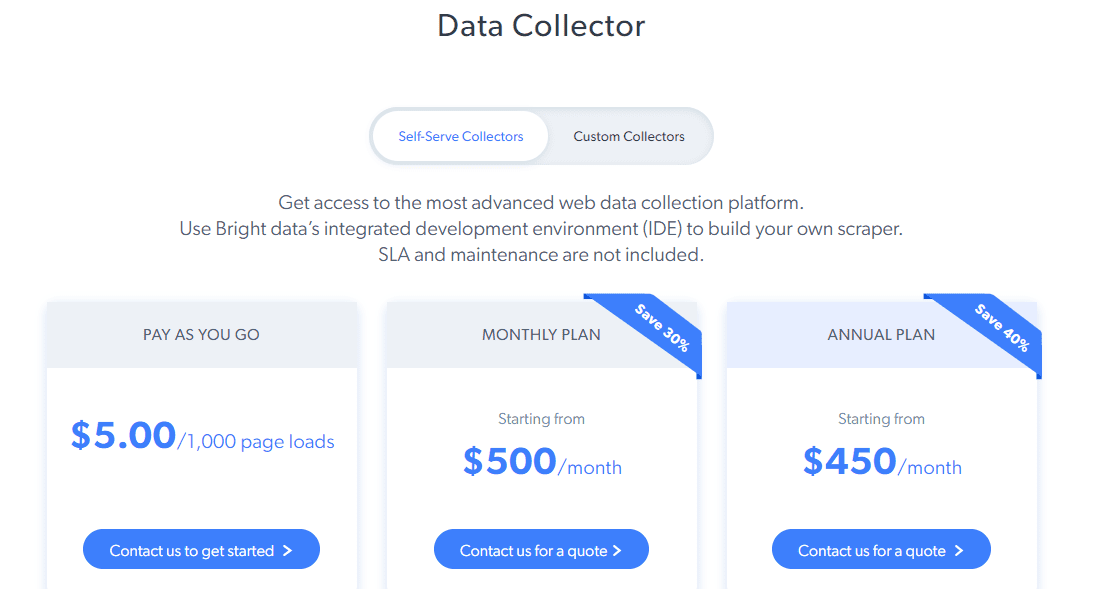

Bright Data Collector bietet zwei Arten von Preisen – Self-Server-Collectors und benutzerdefinierte Collectors.

Self-Serve Collector: Sie erhalten Zugriff auf erweiterte Funktionen wie die IDE von Bright Data, um Ihren Web Scraper zu erstellen, Warnungen, Überwachung der Erfolgsrate, schnellere Leistung, branchenüblichen Proxy und mehr. Seine Preispläne sind:

- Pay As You Go: 5 $ pro 1.000 Seitenladevorgänge

- Monatsplan: Beginnt bei 500 $ pro Monat

- Jahresplan: Beginnt bei 450 $ pro Monat

Für benutzerdefinierte Sammler beginnt der Preis bei 1.000 $ pro Monat.

Es gibt auch eine KOSTENLOSE Testoption für einen begrenzten Zeitraum, um zu entscheiden, ob es für Ihren Anwendungsfall geeignet ist.

Alternativen zu Bright Data Collector

Nicht jedes Produkt passt zu jedem. Egal, ob es sich um Preise, Funktionen oder Richtlinien handelt, einige Leute mögen Bright Data Collector aus irgendeinem Grund möglicherweise nicht. Also, wenn Sie so jemand sind, schauen wir uns einige der besten Alternativen zu Bright Data Collector an.

Oxylabs

Die beliebte Plattform Oxylabs bietet eine hervorragende Web-Scraper-API, mit der Sie mühelos Daten sammeln können.

Hauptmerkmale

- Hochwertige Datenerfassung von jeder Website mithilfe des patentierten Proxy-Rotators

- Sammeln von Daten aus 195 Ländern

- Einfach zu umgehende geografische Beschränkungen

- Wartungsfrei

- Sie zahlen nur für erfolgreich übermittelte Daten

Sie können es 7 Tage lang kostenlos testen oder einen Plan ab 99 $ pro Monat wählen.

Smartproxy

Wenn Sie nach einer anderen No-Code-Plattform für Web Scraping als Bright Data suchen, versuchen Sie es mit Smartproxy. Es hilft Ihnen, Ihre Web-Scraping-Aufgaben zu planen und Daten ohne Codierung sicher zu speichern.

Hauptmerkmale

- Fantastische vorgefertigte Scraping-Vorlagen

- Ein-Klick-Einrichtung

- Datenexport in CSV oder JSON

- Cloud-Datenspeicherung

- Kostenlose Chrome-Erweiterung

Testen Sie Smartproxy 3 Tage lang KOSTENLOS oder wählen Sie einen Plan ab 50 $ pro Monat.

Zyte

Zyte bietet eine automatisierte Web-Datenextraktions-API, um eine zuverlässige, schnellere und sichere Datenerfassung zu ermöglichen, ohne von Websites gesperrt zu werden. Es verfügt über eine patentierte KI-Technologie für die automatisierte Extraktion, damit Sie qualitativ hochwertige Daten in der Struktur bereitstellen können.

Hauptmerkmale

- Schnelle Antworten

- Hochwertige Daten von zehn Typen

- Vereinfachte HTTP-API

- 40+ Sprachunterstützung

- Passt sich Standortänderungen an

- Eingebautes Anti-Ban-Management

- Unbegrenzter Maßstab

Der Preisplan beginnt bei 60 US-Dollar pro Monat, und die KOSTENLOSE Testversion ist 14 Tage lang verfügbar.

Fazit

Die Verwendung eines Datenerfassungstools wie Bright Data Collector kann Ihren Web-Scraping-Prozess mit seiner intuitiven Benutzeroberfläche, zuverlässigen Leistung und nützlichen Funktionen erheblich vereinfachen.

Wenn Sie also eine Organisation, Universität oder ein Forschungsunternehmen sind, könnte diese Plattform eine gute Option sein. Wenn Sie jedoch immer noch nach Bright Data-Alternativen suchen, sehen Sie sich die Optionen oben an und wählen Sie diejenige aus, die Ihren Anforderungen entspricht.

Sie können auch einige beliebte Cloud-basierte Web-Scraping-Lösungen erkunden.