Mit der Einführung neuer Technologien wie Deep Learning, KI und ML sind Cloud-GPUs sehr gefragt.

Wenn sich Ihre Organisation mit 3D-Visualisierungen, maschinellem Lernen (ML), künstlicher Intelligenz (KI) oder irgendeiner Art von Heavy Computing befasst, ist es sehr wichtig, wie Sie GPU-Berechnungen durchführen.

Traditionell nahmen Deep-Learning-Modelle in Organisationen viel Zeit für Trainings- und Berechnungsaufgaben in Anspruch. Früher hat es ihre Zeit totgeschlagen, sie viel gekostet und sie mit Lager- und Platzproblemen zurückgelassen, was die Produktivität verringert hat.

Die New-Age-GPUs wurden entwickelt, um dieses Problem zu lösen. Sie bieten eine hohe Effizienz, um umfangreiche Berechnungen und ein schnelleres Training für Ihre KI-Modelle parallel durchzuführen.

Laut Indigo Research können GPUs bieten 250 Mal schneller Leistung als CPUs, während neuronale Netze trainiert werden, die mit Deep Learning verbunden sind.

Und mit dem Fortschritt des Cloud Computing haben wir jetzt Cloud-GPUs, die die Welt der Datenwissenschaft und anderer neuer Technologien verändern, indem sie noch schnellere Leistung, einfache Wartung, reduzierte Kosten, schnelle Skalierung und Zeitersparnis bieten.

Dieser Artikel stellt Ihnen Cloud-GPU-Konzepte vor, wie sie sich auf KI, ML, Deep Learning und einige der besten Cloud-GPU-Plattformen beziehen, die Sie finden können, um Ihre bevorzugte Cloud-GPU bereitzustellen.

Lass uns anfangen!

Inhaltsverzeichnis

Was ist eine Cloud-GPU?

Um eine Cloud-GPU zu verstehen, lassen Sie uns zuerst über GPUs sprechen.

Eine Grafikverarbeitungseinheit (GPU) bezieht sich auf eine spezialisierte elektronische Schaltung, die verwendet wird, um den Speicher schnell zu ändern und zu manipulieren, um die Erstellung von Bildern oder Grafiken zu beschleunigen.

Moderne GPUs bieten aufgrund ihrer parallelen Struktur eine höhere Effizienz bei der Manipulation von Bildverarbeitung und Computergrafik als Central Processing Units (CPUs). Eine GPU ist auf ihrer Hauptplatine eingebettet oder auf der Grafikkarte oder dem CPU-Chip eines PCs platziert.

Cloud Graphics Units (GPUs) sind Computerinstanzen mit robuster Hardwarebeschleunigung, die für die Ausführung von Anwendungen hilfreich sind, um massive KI- und Deep-Learning-Workloads in der Cloud zu bewältigen. Sie müssen keine physische GPU auf Ihrem Gerät bereitstellen.

Einige beliebte GPUs sind NVIDIA, AMD, Radeon, GeForce und mehr.

GPUs werden verwendet in:

- Mobiltelefone

- Spielekonsole

- Arbeitsplätze

- Eingebettete Systeme

- Persönliche Computer

Wofür werden GPUs verwendet:

Hier sind einige Anwendungsfälle von GPUs:

- In KI und ML zur Bilderkennung

- Berechnungen für 3D-Computergrafiken und CAD-Zeichnungen

- Textur-Mapping und Rendering-Polygone

- Geometrische Berechnungen wie Translationen und Rotationen von Scheitelpunkten in Koordinatensysteme

- Unterstützung programmierbarer Shader zur Manipulation von Texturen und Scheitelpunkten

- GPU-beschleunigte Videocodierung, -decodierung und -streaming

- Grafikreiches Gaming und Cloud-Gaming

- Umfassende mathematische Modellierung, Analytik und Deep Learning, die parallele Verarbeitungsfunktionen von Allzweck-GPUs erfordern.

- Videobearbeitung, Grafikdesign und Content-Erstellung

Was sind die Vorteile von Cloud-GPUs? 👍

Die Hauptvorteile der Verwendung von Cloud-GPUs sind:

Hochgradig skalierbar

Wenn Sie Ihre Organisation erweitern möchten, wird die Arbeitsbelastung schließlich zunehmen. Sie benötigen eine GPU, die mit Ihrer erhöhten Arbeitslast skaliert werden kann. Cloud-GPUs können Ihnen dabei helfen, indem Sie problemlos weitere GPUs hinzufügen können, damit Sie Ihre gestiegenen Arbeitslasten bewältigen können. Wollen Sie umgekehrt skalieren, ist dies auch schnell möglich.

Minimiert die Kosten

Anstatt physische GPUs mit hoher Leistung zu kaufen, die unglaublich teuer sind, können Sie sich für Cloud-GPUs entscheiden, die auf Stundenbasis zu geringeren Kosten erhältlich sind. Ihnen wird die Anzahl der Stunden in Rechnung gestellt, die Sie die Cloud-GPUs verwendet haben, im Gegensatz zu den physischen GPUs, die Sie viel gekostet hätten, obwohl Sie sie nicht viel verwenden.

Löscht lokale Ressourcen

Cloud-GPUs verbrauchen Ihre lokalen Ressourcen nicht, im Gegensatz zu physischen GPUs, die viel Platz auf Ihrem Computer belegen. Ganz zu schweigen davon, wenn Sie ein umfangreiches ML-Modell ausführen oder eine Aufgabe rendern, verlangsamt dies Ihren Computer.

Dazu können Sie erwägen, die Rechenleistung in die Cloud auszulagern, ohne Ihren Computer zu belasten und ihn mit Leichtigkeit zu nutzen. Verwenden Sie einfach den Computer, um alles zu steuern, anstatt ihm den ganzen Druck auszuüben, um die Arbeitslast und die Rechenaufgaben zu bewältigen.

Spart Zeit

Cloud-GPUs geben Designern die Flexibilität einer schnellen Iteration mit schnelleren Rendering-Zeiten. Sie können viel Zeit sparen, indem Sie eine Aufgabe in Minuten erledigen, die früher Stunden oder Tage gedauert hat. Dadurch wird die Produktivität Ihres Teams erheblich gesteigert, sodass Sie Zeit in Innovation statt in Rendering oder Berechnungen investieren können.

Wie helfen GPUs bei Deep Learning und KI?

Deep Learning ist die Grundlage der künstlichen Intelligenz. Es handelt sich um eine fortschrittliche ML-Technik, die das repräsentationale Lernen mit Hilfe von künstlichen neuronalen Netzen (KNNs) betont. Das Deep-Learning-Modell wird verwendet, um große Datenmengen oder hoch rechenintensive Prozesse zu verarbeiten.

Wie kommen also GPUs ins Spiel?

GPUs sind darauf ausgelegt, parallele Berechnungen oder mehrere Berechnungen gleichzeitig durchzuführen. GPUs können die Fähigkeit des Deep-Learning-Modells nutzen, um große Rechenaufgaben zu beschleunigen.

Da GPUs viele Kerne haben, bieten sie hervorragende Parallelverarbeitungsberechnungen. Darüber hinaus verfügen sie über eine höhere Speicherbandbreite, um riesige Datenmengen für Deep-Learning-Systeme aufzunehmen. Daher werden sie häufig zum Trainieren von KI-Modellen, zum Rendern von CAD-Modellen, zum Spielen von grafikreichen Videospielen und mehr verwendet.

Wenn Sie mit mehreren Algorithmen gleichzeitig experimentieren möchten, können Sie außerdem zahlreiche GPUs separat ausführen. Es erleichtert verschiedene Prozesse auf separaten GPUs ohne Parallelität. Dazu können Sie mehrere GPUs auf verschiedenen physischen Computern oder auf einem einzelnen Computer verwenden, um umfangreiche Datenmodelle zu verteilen.

So können Sie mit der Cloud-GPU beginnen

Der Einstieg in Cloud-GPUs ist keine Raketenwissenschaft. Tatsächlich ist alles einfach und schnell, wenn Sie die Grundlagen verstehen. Zunächst müssen Sie einen Cloud-GPU-Anbieter auswählen, z. B. Google Cloud Platform (GCP).

Melden Sie sich als Nächstes für die GCP an. Hier können Sie alle damit verbundenen Standardvorteile wie Cloud-Funktionen, Speicheroptionen, Datenbankverwaltung, Integration mit Anwendungen und mehr nutzen. Sie können auch das Google Colboratory verwenden, das wie Jupyter Notebook funktioniert, um eine GPU KOSTENLOS zu verwenden. Schließlich können Sie mit dem Rendern von GPUs für Ihren Anwendungsfall beginnen.

Schauen wir uns also verschiedene Optionen an, die Sie für Cloud-GPUs haben, um KI und massive Workloads zu bewältigen.

Linode

Linode bietet On-Demand-GPUs für Parallelverarbeitungs-Workloads wie Videoverarbeitung, wissenschaftliches Rechnen, maschinelles Lernen, KI und mehr. Es bietet GPU-optimierte VMs, die durch NVIDIA Quadro RTX 6000-, Tensor- und RT-Kerne beschleunigt werden, und nutzt die CUDA-Leistung, um Raytracing-Workloads, Deep Learning und komplexe Verarbeitung auszuführen.

Verwandeln Sie Ihre Kapitalausgaben in Betriebsausgaben, indem Sie den Zugriff von Linode GPU nutzen, um die GPU-Leistung zu nutzen und vom echten Wertversprechen der Cloud zu profitieren. Außerdem können Sie sich mit Linode auf die Kernkompetenzen konzentrieren, anstatt sich um die Hardware zu kümmern.

Linode-GPUs beseitigen die Barriere, um sie für komplexe Anwendungsfälle wie Video-Streaming, KI und maschinelles Lernen zu nutzen. Darüber hinaus erhalten Sie bis zu 4 Karten für jede Instanz, abhängig von der Leistung, die Sie für die geplante Arbeitslast benötigen.

Quadro RTX 6000 verfügt über 4.608 CUDA-Kerne, 576 Tensor-Kerne, 72 RT-Kerne, 24 GB GDDR6-GPU-Speicher, 84T RTX-OPS, 10 Giga Rays/sec Rays Cast und eine FP32-Leistung von 16,3 TFLOPs.

Der Preis für den dedizierten Plus-RTX6000-GPU-Plan beträgt 1,5 $/Stunde.

Papierbereich CORE

Optimieren Sie Ihren organisatorischen Workflow mit der beschleunigten Computing-Infrastruktur der nächsten Generation von Papierbereich CORE. Es bietet eine benutzerfreundliche und unkomplizierte Oberfläche, um einfaches Onboarding, Tools für die Zusammenarbeit und Desktop-Apps für Mac, Linux und Windows bereitzustellen. Verwenden Sie es, um Anwendungen mit hoher Nachfrage durch unbegrenzte Rechenleistung auszuführen.

CORE bietet ein blitzschnelles Netzwerk, sofortige Bereitstellung, 3D-App-Unterstützung und eine vollständige API für den programmgesteuerten Zugriff. Verschaffen Sie sich einen vollständigen Überblick über Ihre Infrastruktur mit einer mühelosen und intuitiven GUI an einem einzigen Ort. Darüber hinaus erhalten Sie eine hervorragende Kontrolle mit der Verwaltungsschnittstelle des CORE, die robuste Tools bietet und es Ihnen ermöglicht, Maschinen, Netzwerke und Benutzer zu filtern, zu sortieren, zu verbinden oder zu erstellen.

Die leistungsstarke Verwaltungskonsole von CORE führt Aufgaben wie das Hinzufügen von Active Directory-Integration oder VPN schnell aus. Sie können auch die komplexen Netzwerkkonfigurationen einfach verwalten und Dinge mit wenigen Klicks schneller erledigen.

Darüber hinaus finden Sie viele Integrationen, die optional, aber für Ihre Arbeit hilfreich sind. Holen Sie sich erweiterte Sicherheitsfunktionen, gemeinsam genutzte Laufwerke und mehr mit dieser Cloud-GPU-Plattform. Genießen Sie die kostengünstigen GPUs, indem Sie Bildungsrabatte, Abrechnungsbenachrichtigungen, eine Sekunde in Rechnung stellen usw. erhalten.

Fügen Sie dem Workflow Einfachheit und Geschwindigkeit zu einem Startpreis von 0,07 $/Stunde hinzu.

Google Cloud-GPUs

Holen Sie sich leistungsstarke GPUs für wissenschaftliches Rechnen, 3D-Visualisierung und maschinelles Lernen Google Cloud-GPUs. Es kann dabei helfen, HPC zu beschleunigen, eine breite Palette von GPUs auszuwählen, die zu Preis und Leistung passen, und Ihre Arbeitslast durch Maschinenanpassungen und flexible Preise minimieren.

Sie bieten auch viele GPUs wie NVIDIA K80, P4, V100, A100, T4 und P100 an. Außerdem gleichen Google Cloud-GPUs Speicher, Prozessor, Hochleistungsfestplatte und bis zu 8 GPUs in jeder Instanz für die individuelle Arbeitslast aus.

Darüber hinaus erhalten Sie Zugriff auf branchenführende Netzwerke, Datenanalysen und Speicher. GPU-Geräte sind in einigen Regionen nur in bestimmten Zonen verfügbar. Der Preis hängt von der Region, der von Ihnen gewählten GPU und dem Maschinentyp ab. Sie können Ihren Preis berechnen, indem Sie Ihre Anforderungen im Google Cloud-Preisrechner definieren.

Alternativ können Sie sich für diese Lösungen entscheiden:

Elastischer GPU-Dienst

Elastischer GPU-Dienst (EGS) bietet parallele und leistungsstarke Rechenfunktionen mit GPU-Technologie. Es ist ideal für viele Szenarien wie Videoverarbeitung, Visualisierung, wissenschaftliches Rechnen und Deep Learning. EGS verwendet mehrere GPUs wie NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 und AMD FirePro S7150.

Sie erhalten Vorteile wie Online-Deep-Learning-Inferenzdienste und -Schulungen, Inhaltsidentifizierung, Bild- und Spracherkennung, HD-Mediencodierung, Videokonferenzen, Quellfilmreparatur und 4K/8K-HD-Live.

Darüber hinaus erhalten Sie Optionen wie Video-Rendering, Computational Finance, Klimavorhersage, Kollisionssimulation, Gentechnik, nichtlineare Bearbeitung, Fernunterrichtsanwendungen und Konstruktionsdesign.

- Die GA1-Instance bietet bis zu 4 AMD FirePro S7150-GPUs, 160 GB Arbeitsspeicher und 56 vCPUs. Es enthält 8192 Kerne und 32 GB GPU-Speicher, die parallel arbeiten und 15 TFLOPS mit einfacher Genauigkeit und ein TFLOPS mit doppelter Genauigkeit liefern.

- Die GN4-Instanz bietet bis zu 2 NVIDIA Tesla M40-GPUs, 96 GB Arbeitsspeicher und 56 vCPUs. Es enthält 6000 Kerne und 24 GB GPU-Speicher, der 14 TFLOPS mit einfacher Genauigkeit liefert. Ebenso finden Sie viele Instanzen wie GN5, GN5i und GN6.

- EGS unterstützt intern 25 Gbit/s und bis zu 2.000.000 PPS Netzwerkbandbreite, um die von den Rechenknoten benötigte maximale Netzwerkleistung bereitzustellen. Es verfügt über einen lokalen Hochgeschwindigkeits-Cache, der mit SSD- oder Ultra-Cloud-Festplatten verbunden ist.

- Leistungsstarke NVMe-Laufwerke verarbeiten 230.000 IOPS mit einer E/A-Latenz von 200 𝝻s und bieten eine Lesebandbreite von 1900 Mbit/s und eine Schreibbandbreite von 1100 Mbit/s.

Sie können je nach Bedarf aus verschiedenen Kaufoptionen wählen, um die Ressourcen zu erhalten, und nur dafür bezahlen.

Azure N-Serie

Azure N-Serie der Azure Virtual Machines (VMs) verfügen über GPU-Funktionen. GPUs sind ideal für grafik- und rechenintensive Workloads und helfen Benutzern, Innovationen durch verschiedene Szenarien wie Deep Learning, Predictive Analytics und Remote-Visualisierung voranzutreiben.

Verschiedene N-Serien haben separate Angebote für bestimmte Workloads.

- Die NC-Serie konzentriert sich auf leistungsstarkes maschinelles Lernen und Computing-Workloads. Die neueste Version ist NCsv3, die NVIDIAs Tesla V100-GPU von NVIDIA enthält.

- Die ND-Serie konzentriert sich auf Inferenz- und Trainingsszenarien im Wesentlichen für Deep Learning. Es verwendet NVIDIA Tesla P40-GPUs. Die neueste Version ist NDv2 mit NVIDIA Tesla V100-GPUs.

- Die NV-Serie konzentriert sich auf die Remote-Visualisierung und andere intensive Anwendungsworkloads, die von der NVIDIA Tesla M60-GPU unterstützt werden.

- Die NC-, NCsv3-, NDs- und NCsv2-VMs bieten eine InfiniBand-Verbindung, die eine skalierbare Leistung ermöglicht. Hier erhalten Sie die Vorteile wie Deep Learning, Grafik-Rendering, Videobearbeitung, Spiele usw.

IBM-Cloud

IBM-Cloud bietet Ihnen Flexibilität, Leistung und viele GPU-Optionen. Da GPU die zusätzliche Intelligenz ist, die einer CPU fehlt, hilft IBM Cloud Ihnen, direkten Zugriff auf die zugänglichere Auswahl des Servers für eine nahtlose Integration mit der IBM Cloud-Architektur, Anwendungen und APIs zusammen mit einem verteilten Netzwerk der Rechenzentren weltweit zu erhalten.

- Sie erhalten Bare-Metal-Server-GPU-Optionen wie Intel Xeon 4210, NVIDIA T4-Grafikkarte, 20 Kerne, 32 GB RAM, 2,20 GHz und 20 TB Bandbreite. In ähnlicher Weise erhalten Sie auch Optionen für Intel Xeon 5218 und Intel Xeon 6248.

- Für virtuelle Server erhalten Sie AC1.8×60 mit acht vCPUs, 60 GB RAM und 1 x P100-GPU. Hier erhalten Sie auch die Optionen AC2.8×60 und AC2.8×60.

Holen Sie sich die Bare-Metal-Server-GPU zu einem Startpreis von 819 $/Monat und die virtuelle Server-GPU zu einem Startpreis von 1,95 $/Stunde.

AWS und NVIDIA

AWS und NVIDIA haben zusammengearbeitet, um kontinuierlich kostengünstige, flexible und leistungsstarke GPU-basierte Lösungen bereitzustellen. Es umfasst NVIDIA-GPU-betriebene Amazon EC2-Instances und Dienste wie AWS IoT Greengrass, das mit NVIDIA Jetson Nano-Modulen bereitgestellt wird.

Benutzer verwenden AWS und NVIDIA für virtuelle Workstations, maschinelles Lernen (ML), IoT-Dienste und Hochleistungs-Computing. Amazon EC2-Instances, die von NVIDIA-GPUs angetrieben werden, sind für die Bereitstellung skalierbarer Leistung verantwortlich. Verwenden Sie außerdem AWS IoT Greengrass, um die AWS-Cloud-Services auf die NVIDIA-basierten Edge-Geräte auszudehnen.

Die NVIDIA A100 Tensor Core-GPUs versorgen Amazon EC2 P4d-Instances mit Strom, um branchenführende Netzwerke mit geringer Latenz und hohem Durchsatz bereitzustellen. Ebenso finden Sie viele andere Instanzen für bestimmte Szenarien wie Amazon EC2 P3, Amazon EC2 G4 usw.

Bewerben Sie sich für die KOSTENLOSE Testversion und erleben Sie die Leistung der GPU bis zum Rand aus der Cloud.

OVHcloud

OVHcloud stellt Cloud-Server bereit, die für die Verarbeitung massiver paralleler Workloads ausgelegt sind. Die GPUs verfügen über viele Instanzen, die in NVIDIA Tesla V100-Grafikprozessoren integriert sind, um die Anforderungen für Deep Learning und maschinelles Lernen zu erfüllen.

Sie helfen, die Datenverarbeitung im Bereich der grafischen Datenverarbeitung sowie der künstlichen Intelligenz zu beschleunigen. OVH arbeitet mit NVIDIA zusammen, um die beste GPU-beschleunigte Plattform für Hochleistungs-Computing, KI und Deep Learning anzubieten.

Verwenden Sie den einfachsten Weg zur Bereitstellung und Wartung von GPU-beschleunigten Containern über einen vollständigen Katalog. Es liefert eine von vier Karten direkt über PCI Passthrough ohne Virtualisierungsebene an die Instanzen, um alle Kräfte für Ihre Nutzung bereitzustellen.

Die Dienste und Infrastrukturen von OVHcloud sind nach ISO/IEC 27017, 27001, 27701 und 27018 zertifiziert. Die Zertifizierungen zeigen, dass OVHcloud über ein Informationssicherheits-Managementsystem (ISMS) verfügt, um Schwachstellen zu verwalten, Geschäftskontinuität zu implementieren, Risiken zu verwalten und ein Datenschutz-Informationsmanagementsystem (PIMS) zu implementieren.

Darüber hinaus verfügt NVIDIA Tesla V100 über viele wertvolle Funktionen wie PCIe 32 GB/s, 16 GB HBM2 Kapazität, 900 GB/s Bandbreite, Double Precision – 7 TeraFLOPs, Single Precision – 14 TeraFLOPs und Deep Learning – 112 TeraFLOPs.

Lambda-GPU

Trainieren Sie Deep Learning-, ML- und KI-Modelle mit Lambda-GPU-Cloud und mit wenigen Klicks von einer Maschine auf die Gesamtzahl der VMs skalieren. Holen Sie sich vorinstallierte Hauptframeworks und die neueste Version des Lambda-Stacks, die CUDA-Treiber und Deep-Learning-Frameworks enthält.

Erhalten Sie über das Dashboard schnellen Zugriff auf die dedizierte Jupyter Notebook-Entwicklungsumgebung für jeden Computer. Verwenden Sie SSH direkt mit einem der SSH-Schlüssel oder verbinden Sie sich über das Webterminal im Cloud-Dashboard für den direkten Zugriff.

Jede Instanz unterstützt maximal 10 Gbit/s Bandbreite zwischen den Knoten, was ein verteiltes Training mit Frameworks wie Horovod ermöglicht. Sie können auch Zeit bei der Modelloptimierung sparen, indem Sie auf die Anzahl der GPUs auf einzelnen oder vielen Instanzen skalieren.

Mit Lambda GPU Cloud können Sie sogar 50 % beim Computing einsparen, die Cloud-TCO reduzieren und erhalten niemals mehrjährige Verpflichtungen. Verwenden Sie eine einzelne RTX 6000-GPU mit sechs VCPUs, 46 GiB RAM, 658 GiB temporärem Speicher für nur 1,25 $/Stunde. Wählen Sie entsprechend Ihren Anforderungen aus vielen Instanzen aus, um einen On-Demand-Preis für Ihre Nutzung zu erhalten.

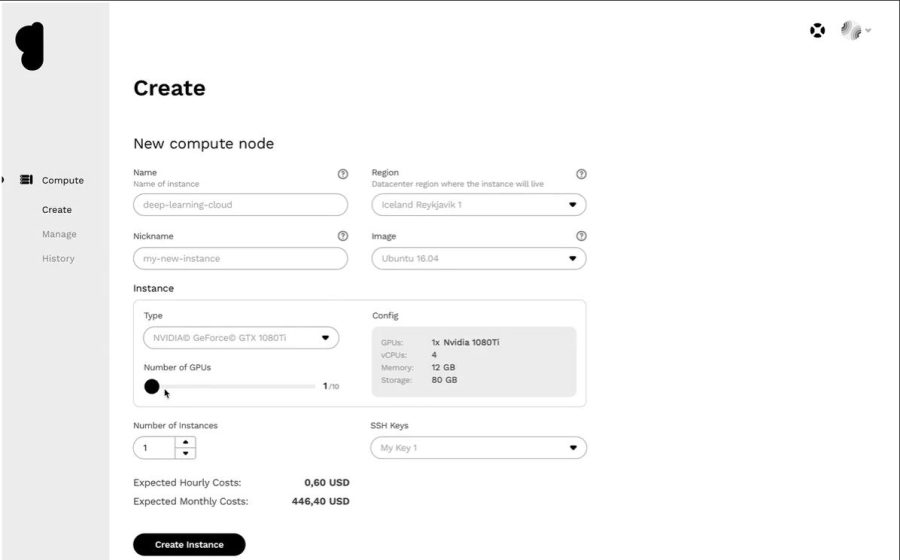

Genesis-Wolke

Holen Sie sich eine effiziente Cloud-GPU-Plattform zu einem sehr günstigen Preis von Genesis-Wolke. Sie haben Zugang zu vielen effizienten Rechenzentren auf der ganzen Welt, mit denen sie zusammenarbeiten, um eine breite Palette von Anwendungen anzubieten.

Alle Dienste sind sicher, skalierbar, robust und automatisiert. Genesis Cloud bietet unbegrenzte GPU-Rechenleistung für visuelle Effekte, maschinelles Lernen, Transcodierung oder Speicherung, Big-Data-Analyse und vieles mehr.

Genesis Cloud bietet KOSTENLOS viele reichhaltige Funktionen, wie z. B. Snapshots zum Speichern Ihrer Arbeit, Sicherheitsgruppen für den Netzwerkverkehr, Speichervolumes für große Datenmengen, FastAI, PyTorch, vorkonfigurierte Bilder und eine öffentliche API für TensorFlow.

Es verfügt über NVIDIA- und AMD-GPUs verschiedener Typen. Trainieren Sie außerdem das neuronale Netzwerk oder erstellen Sie Animationsfilme, indem Sie die Leistungsfähigkeit des GPU-Computing nutzen. Ihre Rechenzentren werden mit 100 % erneuerbarer Energie aus geothermischen Quellen betrieben, um die CO2-Emissionen zu senken.

Ihre Preise sind 85 % niedriger als bei anderen Anbietern, da Sie für Minutenstufen zahlen. Sie können auch mit langfristigen und präemptiven Rabatten mehr sparen.

Fazit 👩🏫

Cloud-GPUs sind darauf ausgelegt, unglaubliche Leistung, Geschwindigkeit, Skalierung, Speicherplatz und Komfort zu bieten. Erwägen Sie daher die Wahl Ihrer bevorzugten Cloud-GPU-Plattform mit sofort einsatzbereiten Funktionen, um Ihre Deep-Learning-Modelle zu beschleunigen und KI-Workloads einfach zu bewältigen.