Daten sind ein unverzichtbarer Bestandteil von Unternehmen und Organisationen und nur dann wertvoll, wenn sie richtig strukturiert und effizient verwaltet werden.

Laut einer Statistik empfinden 95 % der Unternehmen heute die Verwaltung und Strukturierung unstrukturierter Daten als Problem.

Hier kommt Data Mining ins Spiel. Es ist der Prozess des Entdeckens, Analysierens und Extrahierens aussagekräftiger Muster und wertvoller Informationen aus großen Mengen unstrukturierter Daten.

Unternehmen verwenden Software, um Muster in großen Datenmengen zu identifizieren, um mehr über ihre Kunden und ihre Zielgruppe zu erfahren und Geschäfts- und Marketingstrategien zu entwickeln, um den Umsatz zu steigern und Kosten zu senken.

Neben diesem Vorteil sind Betrugs- und Anomalieerkennung die wichtigsten Anwendungen von Data Mining.

Dieser Artikel erläutert die Anomalieerkennung und untersucht weiter, wie sie dazu beitragen kann, Datenschutzverletzungen und Netzwerkeinbrüche zu verhindern, um die Datensicherheit zu gewährleisten.

Inhaltsverzeichnis

Was ist Anomalieerkennung und ihre Typen?

Während es beim Data Mining darum geht, Muster, Korrelationen und Trends zu finden, die miteinander verknüpft sind, ist es eine großartige Möglichkeit, Anomalien oder Ausreißerdatenpunkte innerhalb des Netzwerks zu finden.

Anomalien im Data Mining sind Datenpunkte, die sich von anderen Datenpunkten im Datensatz unterscheiden und vom normalen Verhaltensmuster des Datensatzes abweichen.

Anomalien können in verschiedene Typen und Kategorien eingeteilt werden, darunter:

- Änderungen in Ereignissen: Beziehen sich auf plötzliche oder systematische Änderungen gegenüber dem vorherigen normalen Verhalten.

- Ausreißer: Kleine anomale Muster, die in nicht systematischer Weise in der Datenerfassung auftreten. Diese können weiter in globale, kontextbezogene und kollektive Ausreißer eingeteilt werden.

- Drifts: Allmähliche, ungerichtete und langfristige Änderung des Datensatzes.

Daher ist die Anomalieerkennung eine Datenverarbeitungstechnik, die sehr nützlich ist, um betrügerische Transaktionen zu erkennen, Fallstudien mit hochklassigem Ungleichgewicht zu behandeln und Krankheiten zu erkennen, um robuste datenwissenschaftliche Modelle zu erstellen.

Beispielsweise möchte ein Unternehmen möglicherweise seinen Cashflow analysieren, um anormale oder wiederkehrende Transaktionen auf ein unbekanntes Bankkonto zu finden, um Betrug aufzudecken und weitere Untersuchungen durchzuführen.

Vorteile der Anomalieerkennung

Die Erkennung von Anomalien im Benutzerverhalten trägt dazu bei, Sicherheitssysteme zu stärken und sie präziser und genauer zu machen.

Es analysiert und interpretiert verschiedene Informationen, die Sicherheitssysteme bereitstellen, um Bedrohungen und potenzielle Risiken innerhalb des Netzwerks zu identifizieren.

Hier sind die Vorteile der Anomalieerkennung für Unternehmen:

- Echtzeiterkennung von Cybersicherheitsbedrohungen und Datenschutzverletzungen, da die Algorithmen der künstlichen Intelligenz (KI) Ihre Daten ständig scannen, um ungewöhnliches Verhalten zu finden.

- Es macht die Verfolgung anomaler Aktivitäten und Muster schneller und einfacher als die manuelle Erkennung von Anomalien und reduziert den Arbeits- und Zeitaufwand, der zum Beheben von Bedrohungen erforderlich ist.

- Minimiert Betriebsrisiken, indem Betriebsfehler wie plötzliche Leistungseinbrüche erkannt werden, bevor sie überhaupt auftreten.

- Es hilft, größere geschäftliche Schäden zu beseitigen, indem es Anomalien schnell erkennt, da Unternehmen ohne ein Anomalie-Erkennungssystem Wochen und Monate brauchen können, um potenzielle Bedrohungen zu identifizieren.

Daher ist die Erkennung von Anomalien ein großer Vorteil für Unternehmen, die umfangreiche Kunden- und Geschäftsdatensätze speichern, um Wachstumschancen zu finden und Sicherheitsbedrohungen und betriebliche Engpässe zu beseitigen.

Techniken der Anomalieerkennung

Die Anomalieerkennung verwendet mehrere Verfahren und Algorithmen für maschinelles Lernen (ML), um Daten zu überwachen und Bedrohungen zu erkennen.

Hier sind die wichtigsten Techniken zur Erkennung von Anomalien:

#1. Techniken des maschinellen Lernens

Techniken des maschinellen Lernens verwenden ML-Algorithmen, um Daten zu analysieren und Anomalien zu erkennen. Die verschiedenen Arten von Algorithmen für maschinelles Lernen zur Erkennung von Anomalien umfassen:

- Clustering-Algorithmen

- Klassifizierungsalgorithmen

- Deep-Learning-Algorithmen

Zu den häufig verwendeten ML-Techniken für die Erkennung von Anomalien und Bedrohungen gehören Support Vector Machines (SVMs), K-Means-Clustering und Autoencoder.

#2. Statistische Methoden

Statistische Techniken verwenden statistische Modelle, um ungewöhnliche Muster (wie ungewöhnliche Schwankungen in der Leistung einer bestimmten Maschine) in den Daten zu erkennen, um Werte zu erkennen, die außerhalb des Bereichs der erwarteten Werte liegen.

Zu den gängigen Techniken zur statistischen Anomalieerkennung gehören Hypothesentests, IQR, Z-Score, modifizierter Z-Score, Dichteschätzung, Boxplot, Extremwertanalyse und Histogramm.

#3. Data-Mining-Techniken

Data-Mining-Techniken verwenden Datenklassifizierungs- und Clustering-Techniken, um Anomalien innerhalb des Datensatzes zu finden. Einige gängige Data-Mining-Anomalietechniken umfassen spektrales Clustering, dichtebasiertes Clustering und Hauptkomponentenanalyse.

Clustering-Data-Mining-Algorithmen werden verwendet, um verschiedene Datenpunkte basierend auf ihrer Ähnlichkeit zu Clustern zu gruppieren, um Datenpunkte und Anomalien zu finden, die außerhalb dieser Cluster liegen.

Andererseits ordnen Klassifizierungsalgorithmen Datenpunkte bestimmten vordefinierten Klassen zu und erkennen Datenpunkte, die nicht zu diesen Klassen gehören.

#4. Regelbasierte Techniken

Wie der Name schon sagt, verwenden regelbasierte Techniken zur Erkennung von Anomalien eine Reihe vordefinierter Regeln, um Anomalien in den Daten zu finden.

Diese Techniken sind vergleichsweise leichter und einfacher einzurichten, können jedoch unflexibel sein und sind möglicherweise nicht effizient bei der Anpassung an sich änderndes Datenverhalten und -muster.

Beispielsweise können Sie ein regelbasiertes System einfach programmieren, um Transaktionen, die einen bestimmten Dollarbetrag überschreiten, als betrügerisch zu kennzeichnen.

#5. Domänenspezifische Techniken

Sie können domänenspezifische Techniken verwenden, um Anomalien in bestimmten Datensystemen zu erkennen. Während sie jedoch bei der Erkennung von Anomalien in bestimmten Domänen hocheffizient sein können, können sie in anderen Domänen außerhalb der angegebenen weniger effizient sein.

Mithilfe domänenspezifischer Techniken können Sie beispielsweise Techniken entwerfen, die speziell darauf abzielen, Anomalien in Finanztransaktionen zu finden. Sie funktionieren jedoch möglicherweise nicht, um Anomalien oder Leistungseinbußen in einer Maschine zu finden.

Bedarf an maschinellem Lernen zur Erkennung von Anomalien

Maschinelles Lernen ist sehr wichtig und äußerst nützlich bei der Erkennung von Anomalien.

Heutzutage müssen die meisten Unternehmen und Organisationen, die eine Ausreißererkennung benötigen, mit riesigen Datenmengen umgehen, von Text, Kundeninformationen und Transaktionen bis hin zu Mediendateien wie Bildern und Videoinhalten.

Es ist so gut wie unmöglich, alle Banktransaktionen und Daten, die jede Sekunde manuell generiert werden, durchzugehen, um aussagekräftige Erkenntnisse zu gewinnen. Darüber hinaus stehen die meisten Unternehmen vor Herausforderungen und großen Schwierigkeiten bei der Strukturierung unstrukturierter Daten und der sinnvollen Anordnung der Daten für die Datenanalyse.

Hier spielen Tools und Techniken wie maschinelles Lernen (ML) eine große Rolle beim Sammeln, Bereinigen, Strukturieren, Ordnen, Analysieren und Speichern riesiger Mengen unstrukturierter Daten.

Techniken und Algorithmen des maschinellen Lernens verarbeiten große Datensätze und bieten die Flexibilität, verschiedene Techniken und Algorithmen zu verwenden und zu kombinieren, um die besten Ergebnisse zu erzielen.

Darüber hinaus trägt maschinelles Lernen auch dazu bei, Anomalieerkennungsprozesse für reale Anwendungen zu rationalisieren und wertvolle Ressourcen zu sparen.

Hier sind einige weitere Vorteile und die Bedeutung des maschinellen Lernens bei der Erkennung von Anomalien:

- Es erleichtert die Erkennung von Skalierungsanomalien, indem es die Identifizierung von Mustern und Anomalien automatisiert, ohne dass eine explizite Programmierung erforderlich ist.

- Algorithmen für maschinelles Lernen sind hochgradig anpassungsfähig an sich ändernde Datensatzmuster, wodurch sie im Laufe der Zeit hocheffizient und robust sind.

- Bewältigt problemlos große und komplexe Datensätze und macht die Anomalieerkennung trotz der Komplexität des Datensatzes effizient.

- Stellt eine frühzeitige Identifizierung und Erkennung von Anomalien sicher, indem Anomalien sofort erkannt werden, was Zeit und Ressourcen spart.

- Auf maschinellem Lernen basierende Anomalieerkennungssysteme tragen dazu bei, im Vergleich zu herkömmlichen Methoden eine höhere Genauigkeit bei der Anomalieerkennung zu erreichen.

Somit hilft die Anomalieerkennung gepaart mit maschinellem Lernen, Anomalien schneller und früher zu erkennen, um Sicherheitsbedrohungen und böswillige Verstöße zu verhindern.

Algorithmen für maschinelles Lernen zur Erkennung von Anomalien

Sie können Anomalien und Ausreißer in Daten mit Hilfe verschiedener Data-Mining-Algorithmen zum Klassifizieren, Clustern oder Lernen von Assoziationsregeln erkennen.

Typischerweise werden diese Data-Mining-Algorithmen in zwei verschiedene Kategorien eingeteilt – überwachte und nicht überwachte Lernalgorithmen.

Überwachtes Lernen

Überwachtes Lernen ist eine gängige Art von Lernalgorithmen, die aus Algorithmen wie Support Vector Machines, logistischer und linearer Regression und Mehrklassenklassifizierung besteht. Dieser Algorithmustyp wird mit gekennzeichneten Daten trainiert, was bedeutet, dass sein Trainingsdatensatz sowohl normale Eingabedaten als auch entsprechende korrekte Ausgaben oder anomale Beispiele enthält, um ein Vorhersagemodell zu erstellen.

Sein Ziel ist es daher, Ausgabevorhersagen für ungesehene und neue Daten basierend auf den Mustern des Trainingsdatensatzes zu treffen. Zu den Anwendungen von überwachten Lernalgorithmen gehören Bild- und Spracherkennung, prädiktive Modellierung und Verarbeitung natürlicher Sprache (NLP).

Unbeaufsichtigtes Lernen

Unüberwachtes Lernen wird nicht mit gekennzeichneten Daten trainiert. Stattdessen entdeckt es komplizierte Prozesse und zugrunde liegende Datenstrukturen, ohne dem Trainingsalgorithmus eine Anleitung zu geben und anstatt spezifische Vorhersagen zu treffen.

Zu den Anwendungen unüberwachter Lernalgorithmen gehören Anomalieerkennung, Dichteschätzung und Datenkomprimierung.

Sehen wir uns nun einige beliebte Algorithmen zur Erkennung von Anomalien an, die auf maschinellem Lernen basieren.

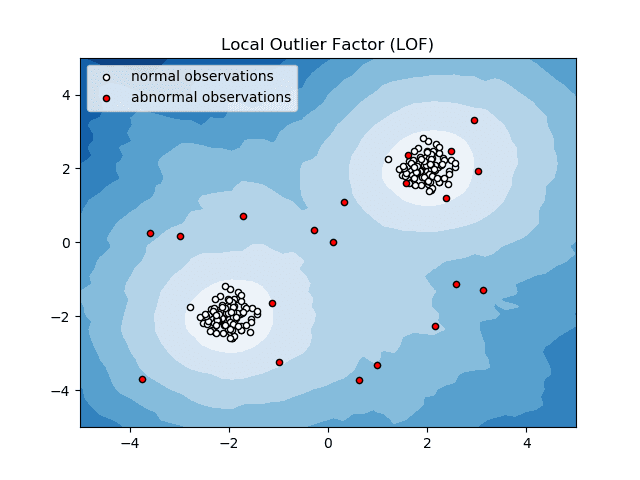

Lokaler Ausreißerfaktor (LOF)

Local Outlier Factor oder LOF ist ein Anomalieerkennungsalgorithmus, der die lokale Datendichte berücksichtigt, um zu bestimmen, ob ein Datenpunkt eine Anomalie ist.

Quelle: scikit-learn.org

Quelle: scikit-learn.org

Es vergleicht die lokale Dichte eines Elements mit der lokalen Dichte seiner Nachbarn, um Bereiche mit ähnlicher Dichte und Elemente mit vergleichsweise geringerer Dichte als ihre Nachbarn zu analysieren – die nichts anderes als Anomalien oder Ausreißer sind.

Vereinfacht ausgedrückt unterscheidet sich also die Dichte um einen Ausreißer oder ein anomales Element herum von der Dichte um seine Nachbarn herum. Daher wird dieser Algorithmus auch als dichtebasierter Ausreißererkennungsalgorithmus bezeichnet.

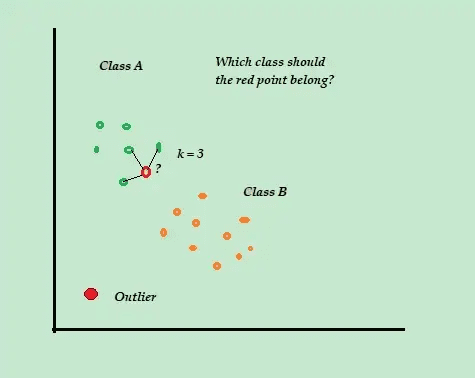

K-nächster Nachbar (K-NN)

K-NN ist der einfachste Algorithmus zur Klassifizierung und überwachten Anomalieerkennung, der einfach zu implementieren ist, alle verfügbaren Beispiele und Daten speichert und die neuen Beispiele basierend auf den Ähnlichkeiten in den Entfernungsmetriken klassifiziert.

Quelle: Towarddatascience.com

Quelle: Towarddatascience.com

Dieser Klassifizierungsalgorithmus wird auch als Lazy Learner bezeichnet, da er nur die markierten Trainingsdaten speichert – ohne während des Trainingsprozesses etwas anderes zu tun.

Wenn der neue unbeschriftete Trainingsdatenpunkt ankommt, betrachtet der Algorithmus die K-nächstgelegenen oder die nächsten Trainingsdatenpunkte, um sie zum Klassifizieren und Bestimmen der Klasse des neuen unbeschrifteten Datenpunkts zu verwenden.

Der K-NN-Algorithmus verwendet die folgenden Erkennungsmethoden, um die nächstgelegenen Datenpunkte zu bestimmen:

- Euklidische Distanz, um die Distanz für kontinuierliche Daten zu messen.

- Hamming-Distanz, um die Nähe oder „Nähe“ der beiden Textzeichenfolgen für diskrete Daten zu messen.

Stellen Sie sich beispielsweise vor, Ihre Trainingsdatensätze bestehen aus zwei Klassenbezeichnungen, A und B. Wenn ein neuer Datenpunkt eintrifft, berechnet der Algorithmus die Entfernung zwischen dem neuen Datenpunkt und jedem der Datenpunkte im Datensatz und wählt die Punkte aus die dem neuen Datenpunkt am nächsten liegen.

Angenommen, K = 3 und 2 von 3 Datenpunkten werden als A gekennzeichnet, dann wird der neue Datenpunkt als Klasse A gekennzeichnet.

Daher funktioniert der K-NN-Algorithmus am besten in dynamischen Umgebungen mit häufigen Datenaktualisierungsanforderungen.

Es ist ein beliebter Anomalieerkennungs- und Textmining-Algorithmus mit Anwendungen im Finanzwesen und in Unternehmen, um betrügerische Transaktionen zu erkennen und die Betrugserkennungsrate zu erhöhen.

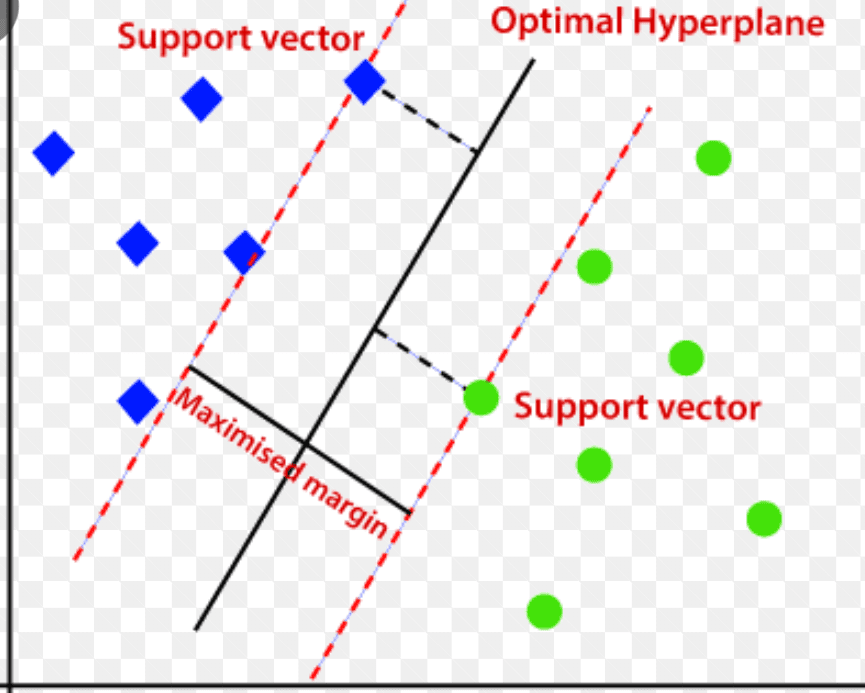

Support Vector Machine (SVM)

Support Vector Machine ist ein überwachter, auf maschinellem Lernen basierender Anomalieerkennungsalgorithmus, der hauptsächlich bei Regressions- und Klassifizierungsproblemen verwendet wird.

Es verwendet eine mehrdimensionale Hyperebene, um Daten in zwei Gruppen (neu und normal) zu unterteilen. Somit fungiert die Hyperebene als Entscheidungsgrenze, die die normalen Datenbeobachtungen und die neuen Daten trennt.

Quelle: www.analyticsvidhya.com

Quelle: www.analyticsvidhya.com

Der Abstand zwischen diesen beiden Datenpunkten wird als Ränder bezeichnet.

Da das Ziel darin besteht, den Abstand zwischen den beiden Punkten zu vergrößern, bestimmt SVM die beste oder optimale Hyperebene mit dem maximalen Spielraum, um sicherzustellen, dass der Abstand zwischen den beiden Klassen so groß wie möglich ist.

In Bezug auf die Anomalieerkennung berechnet SVM den Abstand der neuen Datenpunktbeobachtung von der Hyperebene, um sie zu klassifizieren.

Wenn die Spanne den festgelegten Schwellenwert überschreitet, wird die neue Beobachtung als Anomalie klassifiziert. Wenn die Spanne gleichzeitig unter dem Schwellenwert liegt, wird die Beobachtung als normal klassifiziert.

Somit sind die SVM-Algorithmen beim Umgang mit hochdimensionalen und komplexen Datensätzen hocheffizient.

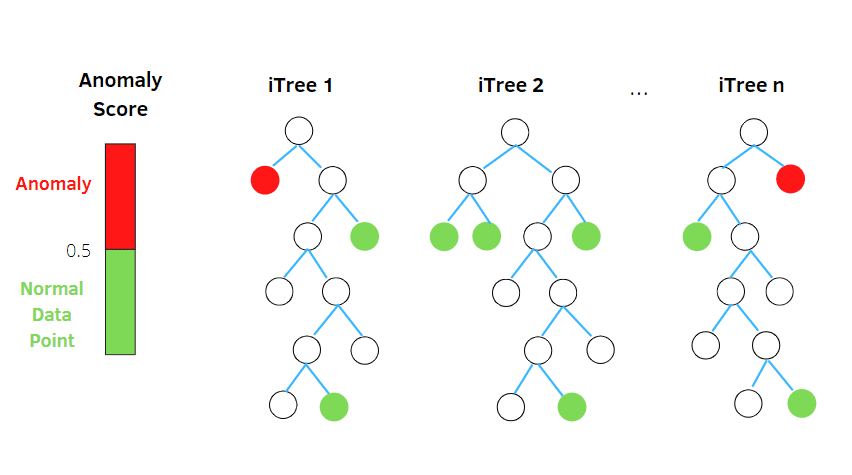

Isolationswald

Isolation Forest ist ein unüberwachter Algorithmus zur Erkennung von Anomalien mit maschinellem Lernen, der auf dem Konzept eines Random-Forest-Klassifikators basiert.

Quelle: betterprogramming.pub

Quelle: betterprogramming.pub

Dieser Algorithmus verarbeitet zufällig unterabgetastete Daten im Datensatz in einer Baumstruktur basierend auf zufälligen Attributen. Es konstruiert mehrere Entscheidungsbäume, um Beobachtungen zu isolieren. Und es betrachtet eine bestimmte Beobachtung als Anomalie, wenn sie aufgrund ihrer Kontaminationsrate in weniger Bäumen isoliert ist.

Einfach ausgedrückt teilt der Isolation-Forest-Algorithmus also die Datenpunkte in verschiedene Entscheidungsbäume auf und stellt so sicher, dass jede Beobachtung von der anderen isoliert wird.

Anomalien liegen in der Regel abseits des Datenpunkt-Clusters, was es einfacher macht, die Anomalien im Vergleich zu den normalen Datenpunkten zu identifizieren.

Algorithmen für isolierte Gesamtstrukturen können problemlos mit kategorialen und numerischen Daten umgehen. Infolgedessen sind sie schneller zu trainieren und hocheffizient bei der Erkennung von Anomalien in hochdimensionalen und großen Datensätzen.

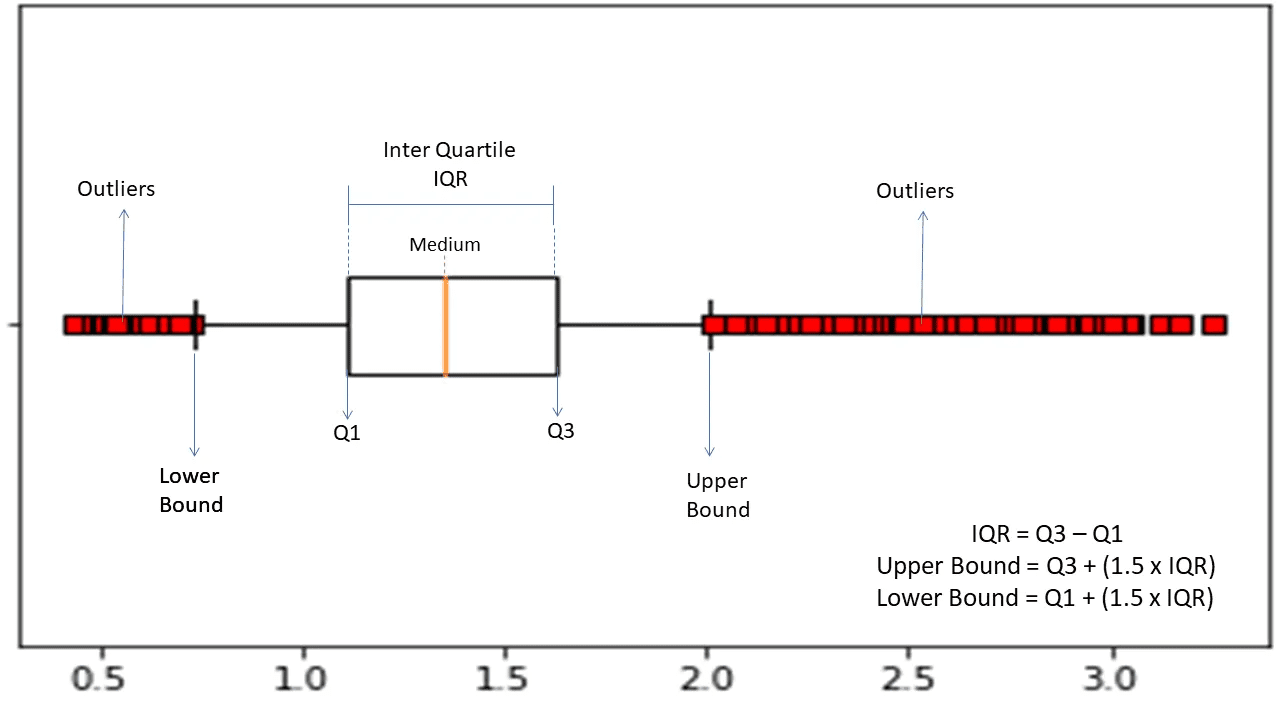

Bereich zwischen den Quartilen

Der Interquartilbereich oder IQR wird verwendet, um die statistische Variabilität oder statistische Streuung zu messen, um anomale Punkte in den Datensätzen zu finden, indem sie in Quartile unterteilt werden.

Quelle: morioh.com

Quelle: morioh.com

Der Algorithmus sortiert die Daten in aufsteigender Reihenfolge und teilt die Menge in vier gleiche Teile. Die Werte, die diese Teile trennen, sind Q1, Q2 und Q3 – erstes, zweites und drittes Quartil.

Hier ist die Perzentilverteilung dieser Quartile:

- Q1 bezeichnet das 25. Perzentil der Daten.

- Q2 bezeichnet das 50. Perzentil der Daten.

- Q3 bezeichnet das 75. Perzentil der Daten.

IQR ist die Differenz zwischen dem dritten (75.) und dem ersten (25.) Perzentil-Datensatz, der 50 % der Daten darstellt.

Die Verwendung von IQR zur Erkennung von Anomalien erfordert, dass Sie den IQR Ihres Datensatzes berechnen und die unteren und oberen Grenzen der Daten definieren, um Anomalien zu finden.

- Untere Grenze: Q1 – 1,5 * IQR

- Obergrenze: Q3 + 1,5 * IQR

Typischerweise werden Beobachtungen, die außerhalb dieser Grenzen liegen, als Anomalien betrachtet.

Der IQR-Algorithmus ist effektiv für Datensätze mit ungleichmäßig verteilten Daten und bei denen die Verteilung nicht gut verstanden wird.

Letzte Worte

Cybersicherheitsrisiken und Datenschutzverletzungen scheinen in den kommenden Jahren nicht einzudämmen – und diese riskante Branche wird voraussichtlich 2023 weiter wachsen, und allein die IoT-Cyberangriffe werden sich voraussichtlich bis 2025 verdoppeln.

Darüber hinaus wird Cyberkriminalität globale Unternehmen und Organisationen bis 2025 jährlich schätzungsweise 10,3 Billionen US-Dollar kosten.

Aus diesem Grund wird der Bedarf an Anomalie-Erkennungstechniken immer häufiger und ist heute für die Betrugserkennung und das Verhindern von Netzwerkeindringlingen erforderlich.

Dieser Artikel hilft Ihnen zu verstehen, was Anomalien beim Data Mining sind, welche Arten von Anomalien es gibt und wie Sie Netzwerkangriffe mithilfe von ML-basierten Anomalieerkennungstechniken verhindern können.

Als Nächstes können Sie alles über die Konfusionsmatrix beim maschinellen Lernen erkunden.