Ihr One-Stop-Erklärer für Deepfakes und ihre einfache Erstellung mit Faceswap.

Künstliche Intelligenz ist nicht mehr so „künstlich“. Diese Zeiten haben es uns Menschen gefährlich nahe gebracht.

Es kann vorschlagen, schreiben, Kunst schaffen und sieht jetzt aus und spricht wie ein Lebender.

Dies ist eine der neuesten Entwicklungen in diesem Bereich, die wir nutzen sollten. Allerdings müssen wir uns auch davor hüten.

Inhaltsverzeichnis

Was sind Deepfakes?

Das Wort Deepfake wird durch die Kombination von Deep Learning und Fake geprägt. Vereinfacht gesagt können Sie auch davon ausgehen, dass es sich um fachmännisch manipulierte oder zutiefst gefälschte Medien handelt.

Laut Wikipedia wird dies auch als synthetisches Medium bezeichnet, bei dem ein vorhandenes Bild, Audio oder Video so modifiziert wird, dass es jemand anderen vollständig darstellt.

Typischerweise lassen Deepfakes renommierte Persönlichkeiten den Anschein erwecken, etwas zu sagen, was sie sonst nicht sagen würden.

Basierend auf den Fähigkeiten seines Schöpfers kann es extrem schwierig sein zu sagen, ob es echt oder gefälscht ist.

Wie funktionieren Deepfakes?

Vereinfacht gesagt wird ein Teil des Originalvideos (z. B. ein Gesicht) durch eine ähnlich aussehende Fälschung ersetzt. In einem solchen Fall kann man es auch Faceswap nennen, wie in diesem ‚Obama‘-Video.

Es ist jedoch nicht nur auf Video beschränkt, und wir haben auch Deepfakes-Bilder und -Audio (und wer weiß, in naher Zukunft Deepfake-VR-Avatare).

Quelle: Disney

Die Arbeitsweise hinter solchen Tricks hängt in erster Linie von der Anwendung und dem zugrunde liegenden Algorithmus ab.

Laut diesem Forschungsbericht von Disney gibt es verschiedene Techniken, darunter Encoder-Decoder, Generative Adversarial Networks (GANs), geometriebasierte Deepfakes usw.

Die folgenden Abschnitte sind jedoch hauptsächlich davon betroffen, wie es mit Facewap funktioniert. Dies ist eine kostenlose Open-Source-Deepfake-Software, die mehrere Algorithmen ermöglicht, um das erwartete Ergebnis zu erzielen.

Es gibt drei Hauptprozesse, um Deepfakes zu generieren: Extraktion, Training und Konvertierung.

#1. Extraktion

Hier geht es um das Auffinden und Herausfiltern des interessierenden Themengebietes aus Medienmustern, dem Original und dem für den Tausch.

Basierend auf den Hardwarefähigkeiten kann es viele Algorithmen geben, um sich für eine effiziente Erkennung zu entscheiden.

Beispielsweise bietet Faceswap einige verschiedene Optionen zum Extrahieren, Ausrichten und Maskieren basierend auf der CPU- oder GPU-Effizienz.

Die Extraktion identifiziert einfach das Gesicht im gesamten Video. Ausrichtungsflecken entscheidende Merkmale jedes Gesichts (Augen, Nase, Kinn usw.). Und schließlich blockiert das Maskieren andere Elemente des Bildes mit Ausnahme des Interessenbereichs.

Die für die Ausgabe benötigte Gesamtzeit ist bei der Auswahl einer Option wichtig, da die Auswahl ressourcenintensiver Algorithmen auf mittelmäßiger Hardware zu Fehlern oder einer erheblich langen Zeit führen kann, um akzeptable Ergebnisse zu erzielen.

Neben der Hardware hängt die Wahl auch von Parametern ab, z. B. ob das Eingangsvideo unter Gesichtsbehinderungen wie Handbewegungen oder Brillen leidet.

Ein notwendiges Element ist am Ende das Bereinigen (später erklärt) der Ausgabe, da die Extraktionen einige falsch positive Ergebnisse aufweisen.

Letztendlich wird die Extraktion für das Originalvideo und die Fälschung (die zum Austauschen verwendet wird) wiederholt.

#2. Ausbildung

Dies ist das Herzstück der Erstellung von Deepfakes.

Beim Training geht es um das neuronale Netz, das aus Encoder und Decoder besteht. Hier werden die Algorithmen mit den extrahierten Daten gefüttert, um später ein Modell für die Konvertierung zu erstellen.

Der Encoder wandelt die Eingabe in eine Vektordarstellung um, um den Algorithmus zu trainieren, die Gesichter wieder aus Vektoren zu erstellen, wie es der Decoder tut.

Anschließend wertet das neuronale Netz seine Iterationen aus und vergleicht sie mit dem Original, indem es einen Verlustwert vergibt. Dieser Verlustwert fällt mit der Zeit, während der Algorithmus weiter iteriert, und Sie stoppen, wenn die Vorschauen akzeptabel sind.

Das Training ist ein zeitaufwändiger Prozess, und die Ergebnisse verbessern sich im Allgemeinen basierend auf den durchgeführten Iterationen und der Qualität der Eingabedaten.

Zum Beispiel schlägt Faceawap ein Minimum von jeweils 500 Bildern vor, sowohl Original- als auch Tauschbilder. Darüber hinaus sollten sich die Bilder deutlich voneinander unterscheiden und alle möglichen Winkel in einzigartiger Beleuchtung für die beste Wiedergabe abdecken.

Aufgrund der Trainingsdauer erlauben einige Anwendungen (wie Faceswap) das Training zwischendurch zu unterbrechen oder später fortzusetzen.

Insbesondere hängt der Fotorealismus der Ausgabe auch von der Effizienz des Algorithmus und der Eingabe ab. Und man wird wieder durch die Hardware-Möglichkeiten eingeschränkt.

#3. Wandlung

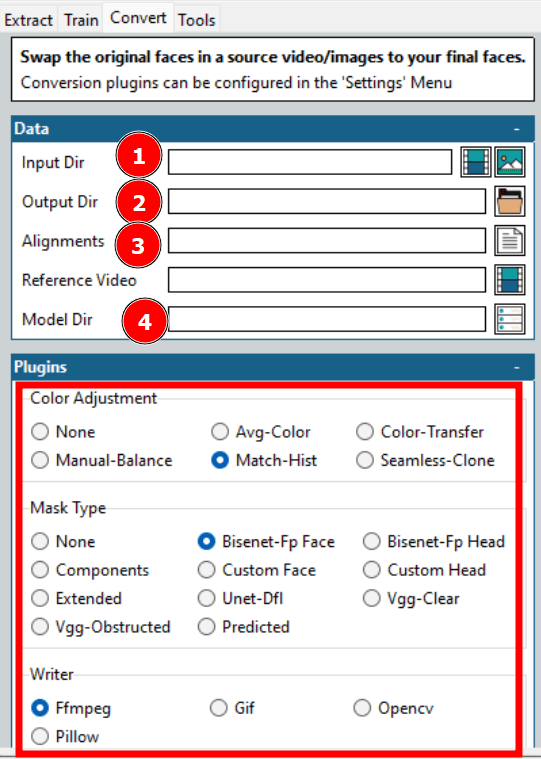

Dies ist das letzte Kapitel in der Deepfake-Erstellung. Die Konvertierungsalgorithmen benötigen das Quellvideo, das trainierte Modell und die Quellausrichtungsdatei.

Anschließend kann man noch einige Optionen bezüglich Farbkorrektur, Maskentyp, gewünschtes Ausgabeformat etc. ändern.

Nachdem Sie diese wenigen Optionen konfiguriert haben, warten Sie einfach auf das endgültige Rendern.

Wie bereits erwähnt, arbeitet Faceswap mit vielen Algorithmen, und man kann zwischen ihnen spielen, um einen erträglichen Faceswap zu erhalten.

Ist das alles?

NEIN!

Das war nur Face-Swapping, eine Teilmenge der Deepfake-Technologie. Face-Swapping, wie die wörtliche Bedeutung, ersetzt nur einen Teil des Gesichts, um eine schwache Vorstellung davon zu geben, was Deepfakes bewirken könnten.

Für einen glaubwürdigen Austausch müssen Sie möglicherweise auch den Ton (besser bekannt als Stimmklonen) und den gesamten Körper nachahmen, einschließlich allem, was in den Rahmen passt, wie folgt:

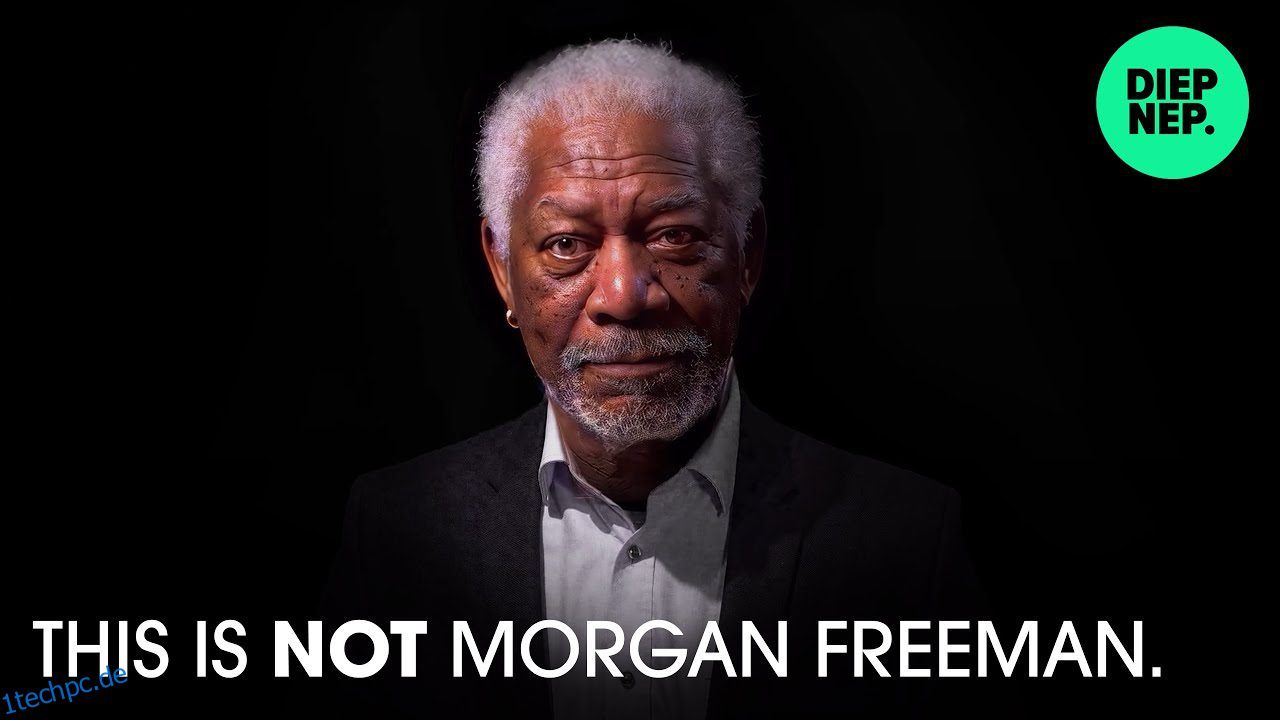

Also, was ist hier im Spiel?

Was passiert sein könnte, ist, dass der Deepfake-Autor das Video selbst gedreht hat (wie in den letzten Sekunden angedeutet), den Dialog mit Morgan Freemans synthetischer Stimme lippensynchronisiert und seinen Kopf ersetzt hat.

Abschließend geht es nicht nur um Faceswap, sondern um den gesamten Frame, einschließlich des Audios.

Sie können auf YouTube unzählige Deepfakes finden, bis es beängstigend wird, wem Sie vertrauen können. Und alles, was Sie brauchen, ist ein leistungsstarker Computer mit einer effizienten Grafikkarte, um zu beginnen.

Perfektion ist jedoch schwer zu erreichen, und das gilt insbesondere für Deepfakes.

Für einen überzeugenden Deepfake, der das Publikum irreführen oder begeistern kann, braucht es Geschick und ein paar Tage bis Wochen der Verarbeitung von ein oder zwei Minuten eines Videos.

Interessanterweise sind diese Algorithmen derzeit so leistungsfähig. Aber was die Zukunft bringt, einschließlich der Frage, wie effektiv diese Anwendungen auf Low-End-Hardware sein können, hat ganze Regierungen nervös gemacht.

Wir werden jedoch nicht auf die zukünftigen Auswirkungen eingehen. Lassen Sie uns stattdessen überprüfen, wie Sie es für wenig Spaß selbst machen können.

Erstellen von (einfachen) Deepfake-Videos

Sie können viele Anwendungen in dieser Liste von Deepfake-Apps zum Erstellen von Memes überprüfen.

Eines davon ist Faceswap, das wir verwenden werden.

Es gibt ein paar Dinge, die wir sicherstellen werden, bevor wir fortfahren. Zunächst sollten wir ein qualitativ hochwertiges Video des Ziels haben, das unterschiedliche Emotionen darstellt. Als Nächstes benötigen wir ein Quellvideo, um auf das Ziel zu wechseln.

Schließen Sie außerdem alle grafikkartenintensiven Anwendungen wie Browser oder Spiele, bevor Sie mit Faceswap fortfahren. Dies gilt insbesondere, wenn Sie weniger als 2 GB VRAM (Video-RAM) haben.

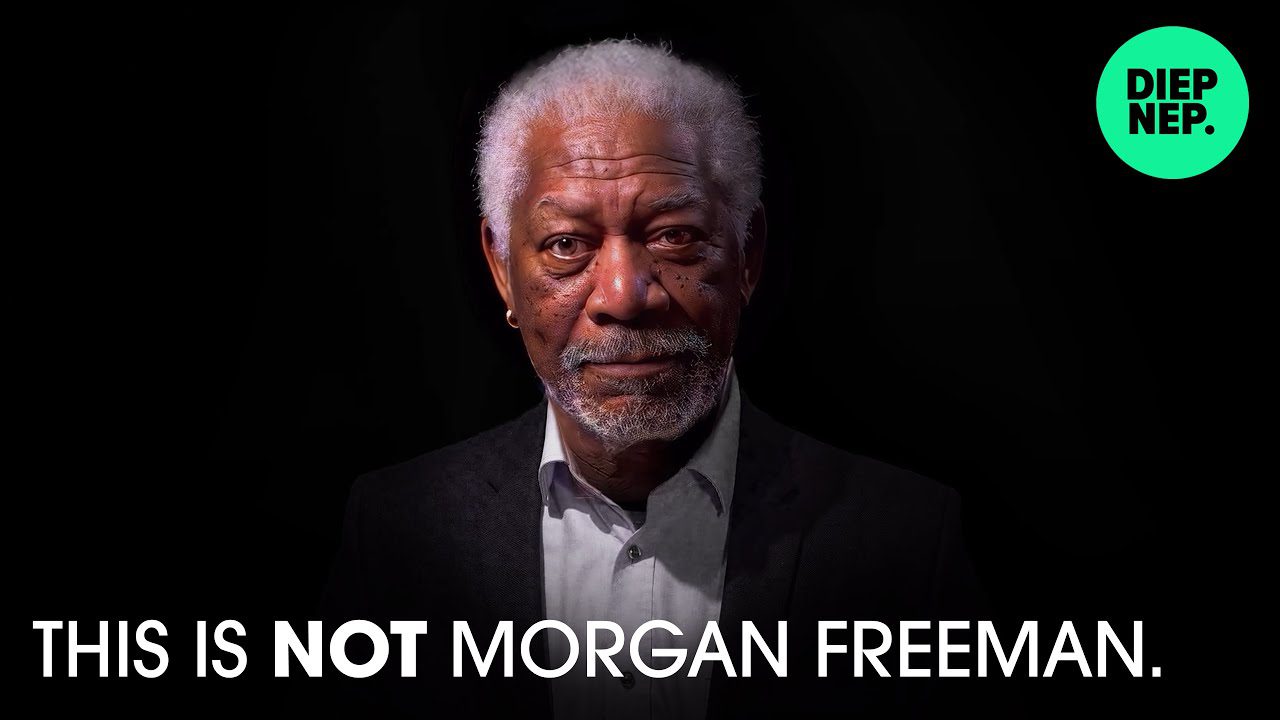

Schritt 1: Gesichter extrahieren

Der erste Schritt in diesem Prozess besteht darin, die Gesichter aus dem Video zu extrahieren. Dazu müssen wir das Zielvideo im Input Dir auswählen und ein Output Dir für die Extraktionen auflisten.

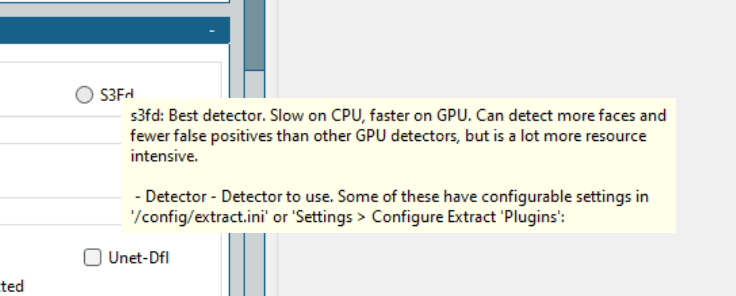

Darüber hinaus gibt es einige Optionen, darunter Detektor, Aligner, Masker usw.; die Erklärungen für jeden finden Sie in den Faceawap-FAQs, und es wäre Verschwendung, die Informationen hier noch einmal aufzuwärmen.

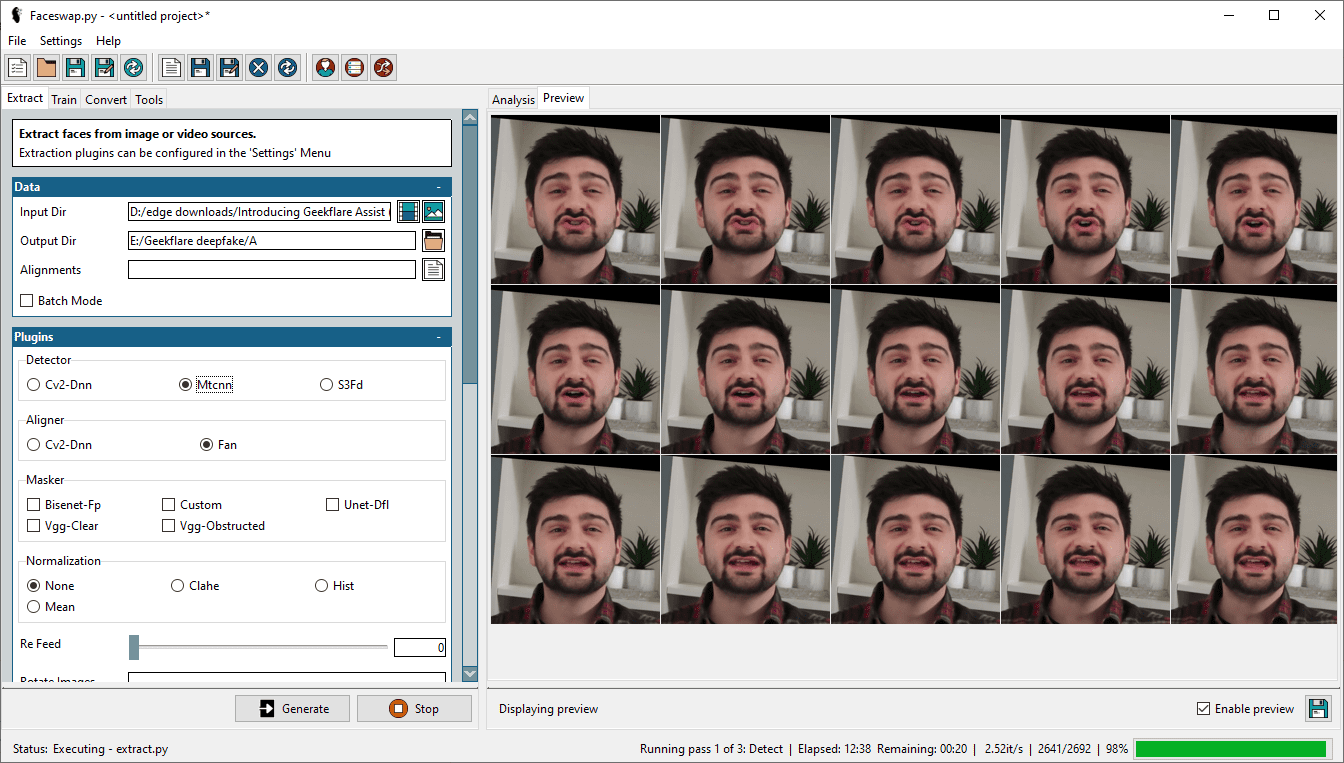

Quelle: Faceswap-FAQ

Quelle: Faceswap-FAQ

Es ist im Allgemeinen gut, die Dokumentation für ein besseres Verständnis und eine anständige Ausgabe zu überprüfen. Es gibt jedoch hilfreiche Texte in Faceswap, die Sie finden können, indem Sie mit der Maus über die jeweilige Option fahren.

Einfach gesagt, es gibt keinen universellen Weg, und man sollte mit den besten Algorithmen beginnen und sich erfolgreich nach unten arbeiten, um einen überzeugenden Deepfake zu erstellen.

Als Kontext habe ich Mtcnn (Detektor), Fan (Aligner) und Bisenet-Fp (Masker) verwendet, während alle anderen Optionen unverändert blieben.

Ursprünglich habe ich es mit S3Fd (bester Detektor) und ein paar anderen Masken kombiniert probiert. Meine 2 GB Nvidia GeForce GTX 750Ti konnte die Hauptlast jedoch nicht ertragen, und der Vorgang schlug wiederholt fehl.

Schließlich habe ich meine Erwartungen und die Einstellungen heruntergeschraubt, um es durchzuziehen.

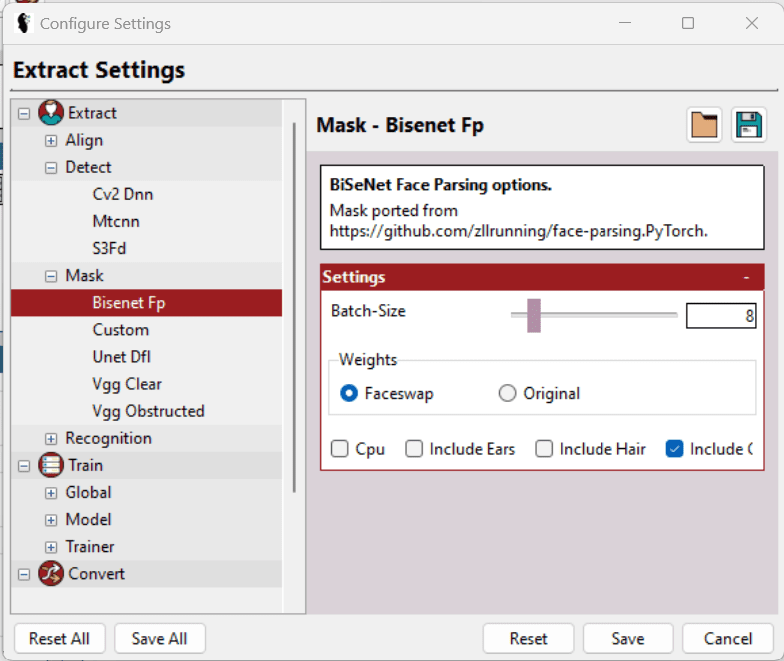

Neben der Auswahl des geeigneten Detektors, der Maskierer usw. gibt es unter Einstellungen > Einstellungen konfigurieren einige weitere Optionen, mit denen einzelne Einstellungen weiter optimiert werden können, um die Hardware zu unterstützen.

Einfach ausgedrückt, wählen Sie die niedrigstmögliche Batch-Size, Input Size und Output Size und aktivieren Sie LowMem usw. Diese Optionen sind nicht universell verfügbar und basieren auf einem bestimmten Abschnitt. Zusätzlich helfen die Hilfetexte weiter bei der Auswahl der besten Optionen.

Obwohl dieses Werkzeug beim Extrahieren von Flächen hervorragende Arbeit leistet, können die Ausgabeframes viel mehr enthalten, als zum Trainieren (später besprochen) des Modells erforderlich ist. Beispielsweise enthält es alle Gesichter (wenn das Video mehr als eines enthält) und einige fehlerhafte Erkennungen, bei denen das Zielgesicht überhaupt nicht vorhanden ist.

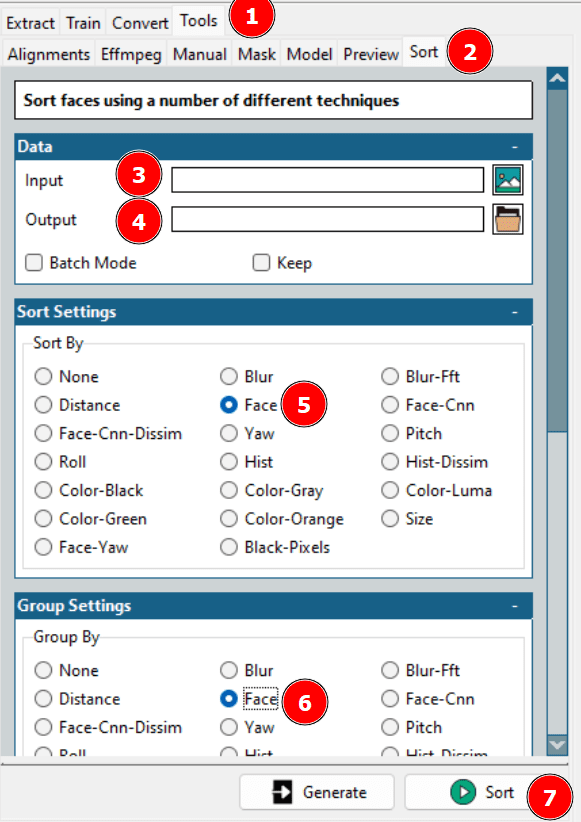

Dies führt zur Bereinigung der Datensätze. Entweder kann man den Ausgabeordner überprüfen und sich selbst löschen oder die Faceswap-Sortierung nutzen, um Hilfe zu bekommen.

Mit dem oben genannten Tool werden verschiedene Gesichter nacheinander angeordnet, von wo aus Sie die erforderlichen in einem einzigen Ordner zusammenfassen und den Rest löschen können.

Zur Erinnerung: Sie sollten auch die Extraktion für das Quellvideo wiederholen.

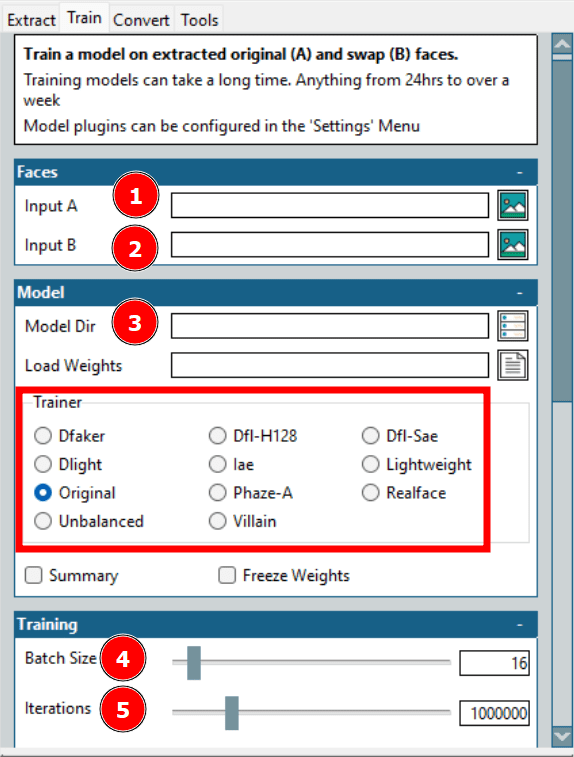

Schritt 2: Modell trainieren

Dies ist der längste Prozess bei der Erstellung eines Deepfakes. Hier bezieht sich Eingang A auf das Zielgesicht und Eingang B auf das Quellgesicht. Außerdem werden im Modellverzeichnis die Trainingsdateien gespeichert.

Hier ist die wichtigste Option Trainer. Es gibt viele mit individuellen Skalierungsoptionen; Was jedoch für meine Hardware funktioniert hat, sind Dfl-H128- und Lightweight-Trainer mit den niedrigsten Konfigurationseinstellungen.

Als nächstes ist die Stapelgröße. Eine höhere Stapelgröße reduziert die Gesamttrainingszeit, verbraucht aber mehr VRAM. Iterationen haben keine festen Auswirkungen auf die Ausgabe, und Sie sollten einen ausreichend hohen Wert festlegen und das Training beenden, sobald die Vorschau akzeptabel ist.

Es gibt ein paar weitere Einstellungen, darunter das Erstellen eines Zeitraffers mit voreingestellten Intervallen; Allerdings habe ich das Modell mit dem Nötigsten trainiert.

Schritt 3: Auf Original umstellen

Dies ist die letzte Meisterleistung in der Deepfake-Erstellung.

Dies dauert im Allgemeinen nicht so lange, und Sie können mit vielen Optionen spielen, um schnell die gewünschte Ausgabe zu erhalten.

Wie im obigen Bild angegeben, sind dies einige Optionen, für die Sie sich entscheiden müssen, um die Konvertierung zu starten.

Die meisten Optionen wurden bereits besprochen, wie das Eingabe- und Ausgabeverzeichnis, das Modellverzeichnis usw. Eine entscheidende Sache sind die Ausrichtungen, die sich auf die Ausrichtungsdatei (.fsa) des Zielvideos beziehen. Es wird während der Extraktion im Eingabeverzeichnis erstellt.

Das Feld Ausrichtungen kann leer gelassen werden, wenn diese bestimmte Datei nicht verschoben wurde. Andernfalls kann man die Datei auswählen und zu anderen Optionen übergehen. Denken Sie jedoch daran, die Alignment-Datei zu bereinigen, wenn Sie die Extraktionen zuvor bereinigt haben.

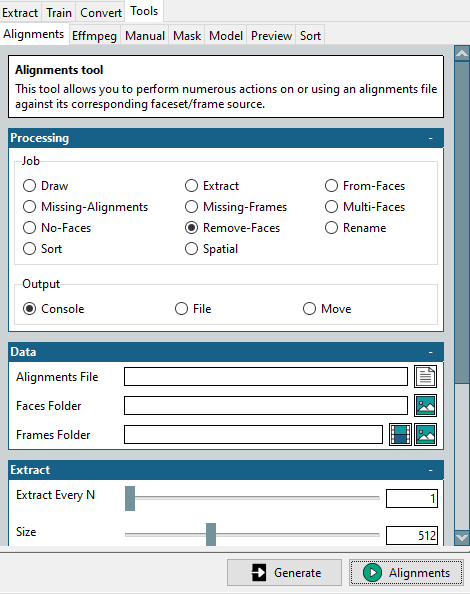

Dazu befindet sich dieses Mini-Tool in den Tools > Alignments.

Beginnen Sie mit der Auswahl von „Gesichter entfernen“ im Abschnitt „Job“, wählen Sie die ursprüngliche Alignment-Datei und den Ordner „Gesäuberte Zielflächen“ aus und klicken Sie unten rechts auf „Alignments“.

Dadurch wird eine modifizierte Ausrichtungsdatei erstellt, die dem optimierten Flächenordner entspricht. Bitte denken Sie daran, dass wir dies für das Zielvideo benötigen, in das wir wechseln möchten.

Einige weitere Konfigurationen umfassen die Farbanpassung und den Maskentyp. Die Farbanpassung bestimmt die Maskenmischung, und Sie können einige ausprobieren, die Vorschau überprüfen und die optimale Option auswählen.

Maskentyp ist wichtiger. Dies hängt wiederum von Ihren Erwartungen und der verfügbaren Hardware ab. In der Regel müssen Sie auch die Eigenschaften des Eingangsvideos berücksichtigen. Zum Beispiel funktioniert Vgg-Clear gut mit frontalen Gesichtern ohne Hindernisse, während Vgg-Obstructed auch mit Hindernissen wie Handgesten, Brillen usw. auskommt.

Als Nächstes präsentiert der Writer einige Auswahlmöglichkeiten basierend auf der gewünschten Ausgabe. Wählen Sie z. B. Ffmpeg für ein Video-Rendering aus.

Insgesamt liegt der Schlüssel zu einem erfolgreichen Deepfake in der Vorschau einiger Ausgaben und der Optimierung entsprechend der Zeitverfügbarkeit und der Leistungsfähigkeit der Hardware.

Anwendungen von Deepfake

Es gibt gute, schlechte und gefährliche Anwendungen von Deepfakes.

Die guten bestehen darin, Geschichtsunterricht von denen nachzubilden, die tatsächlich für ein größeres Engagement da waren.

Darüber hinaus werden sie von Online-Lernplattformen genutzt, um aus Texten Videos zu generieren.

Aber einer der größten Nutznießer wird die Filmindustrie sein. Hier wird es einfach sein, sich den eigentlichen Hauptdarsteller vorzustellen, der Stunts ausführt, selbst wenn es die Stuntperson sein wird, die ihr Leben riskiert. Darüber hinaus wird das Erstellen mehrsprachiger Filme einfacher als je zuvor.

Kommen wir zu den schlechten, leider gibt es viele. Tatsächlich ist die bisher größte Deepfake-Anwendung, 96 % (laut diesem Deeptrace-Bericht), in der Pornoindustrie, um Promi-Gesichter auf Pornodarsteller zu tauschen.

Darüber hinaus werden Deepfakes auch gegen „normale“ nicht prominente Frauen eingesetzt. Normalerweise haben solche Opfer hochwertige Fotos oder Videos auf ihren Social-Media-Profilen, die für die Erstellung von Deepfakes verwendet werden.

Eine weitere beängstigende Anwendung ist Vishing, auch bekannt als Voice-Phishing. In einem solchen Fall überwies der CEO einer in Großbritannien ansässigen Firma auf Anweisung des „CEO“ ihrer deutschen Muttergesellschaft 243.000 US-Dollar, nur um später herauszufinden, dass es sich tatsächlich um einen Deepfake-Anruf handelte.

Aber noch gefährlicher ist es, wenn Deepfakes Kriege provozieren oder zur Kapitulation auffordern. Bei einem jüngsten Versuch forderte der ukrainische Präsident Wolodymyr Selenskyj seine Streitkräfte und sein Volk auf, sich im andauernden Krieg zu ergeben. Die Wahrheit wurde diesmal jedoch durch das unterdurchschnittliche Video verraten.

Zusammenfassend lässt sich sagen, dass es viele Deepfake-Anwendungen gibt, und es fängt gerade erst an.

Das bringt uns zur Millionen-Dollar-Frage …

Ist Deepfakes legal?

Dies hängt maßgeblich von der örtlichen Verwaltung ab. Allerdings sind klar definierte Gesetze, einschließlich dessen, was zulässig ist und was nicht, noch abzuwarten.

Offensichtlich hängt es jedoch davon ab, wofür Sie die Deepfakes verwenden – die Absicht. Es schadet kaum, jemanden zu unterhalten oder zu erziehen, ohne das Tauschziel zu stören.

Andererseits sollten böswillige Anwendungen unabhängig von der Rechtsprechung strafbar sein. Eine weitere Grauzone sind Urheberrechtsverletzungen, die angemessen berücksichtigt werden müssen.

Aber um es noch einmal zu wiederholen, Sie sollten sich bei Ihren lokalen Regierungsbehörden über legale Deepfake-Anwendungen erkundigen.

Pass auf!

Deepfkaes nutzt künstliche Intelligenz, um jeden dazu zu bringen, Dinge zu sagen.

Vertrauen Sie nichts, was Sie im Internet sehen, ist der erste Ratschlag, dem wir folgen sollten. Es gibt Tonnen von Fehlinformationen, und ihre Wirksamkeit nimmt nur zu.

Und da es nur einfacher wird, sie zu erstellen, ist es an der Zeit, dass wir lernen, wie man Deepfakes erkennt.