Eine Konfusionsmatrix ist ein Werkzeug zur Bewertung der Leistung des Klassifikationstyps von Algorithmen für überwachtes maschinelles Lernen.

Inhaltsverzeichnis

Was ist eine Verwirrungsmatrix?

Wir Menschen nehmen die Dinge anders wahr – sogar Wahrheit und Lüge. Was für mich wie eine 10 cm lange Linie erscheint, mag für Sie wie eine 9 cm lange Linie erscheinen. Aber der tatsächliche Wert kann 9, 10 oder etwas anderes sein. Was wir schätzen, ist der vorhergesagte Wert!

Wie das menschliche Gehirn denkt

So wie unser Gehirn unsere eigene Logik anwendet, um etwas vorherzusagen, wenden Maschinen verschiedene Algorithmen (sogenannte maschinelle Lernalgorithmen) an, um zu einem vorhergesagten Wert für eine Frage zu gelangen. Auch diese Werte können mit dem tatsächlichen Wert identisch sein oder sich von diesem unterscheiden.

In einer wettbewerbsorientierten Welt möchten wir wissen, ob unsere Vorhersage richtig ist oder nicht, um unsere Leistung zu verstehen. Auf die gleiche Weise können wir die Leistung eines maschinellen Lernalgorithmus anhand der Anzahl korrekter Vorhersagen bestimmen.

Was ist also ein maschineller Lernalgorithmus?

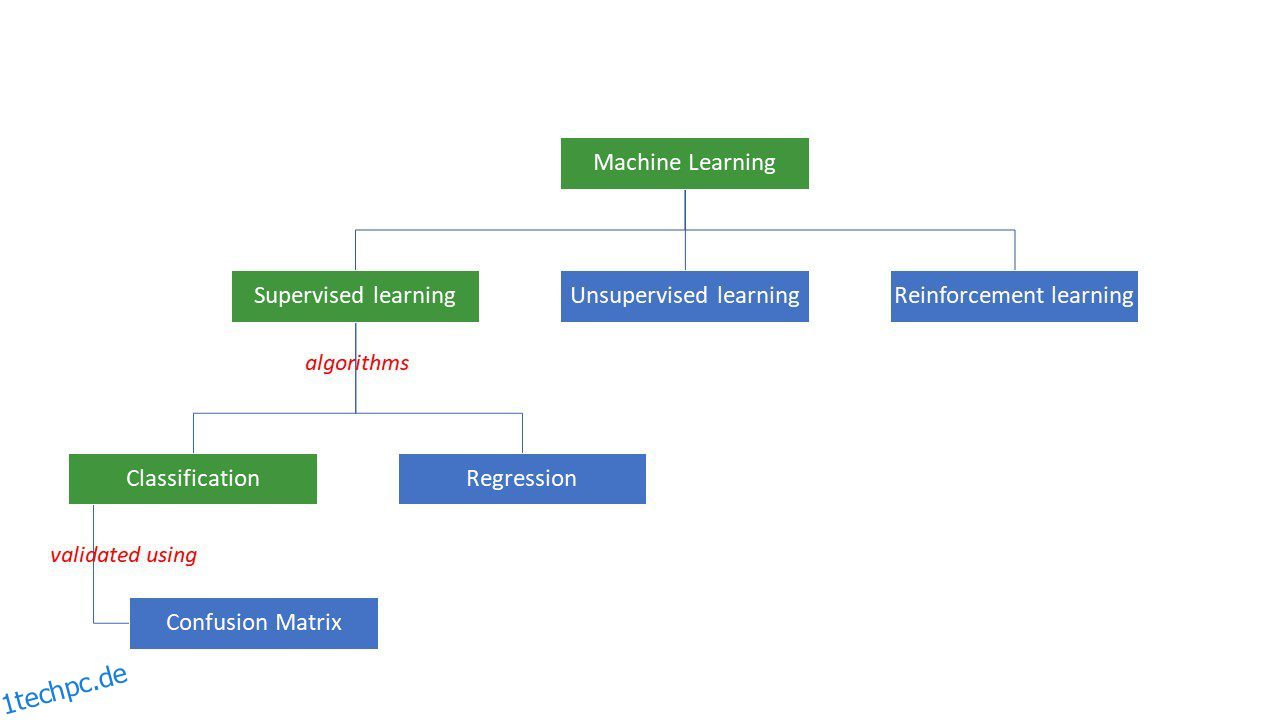

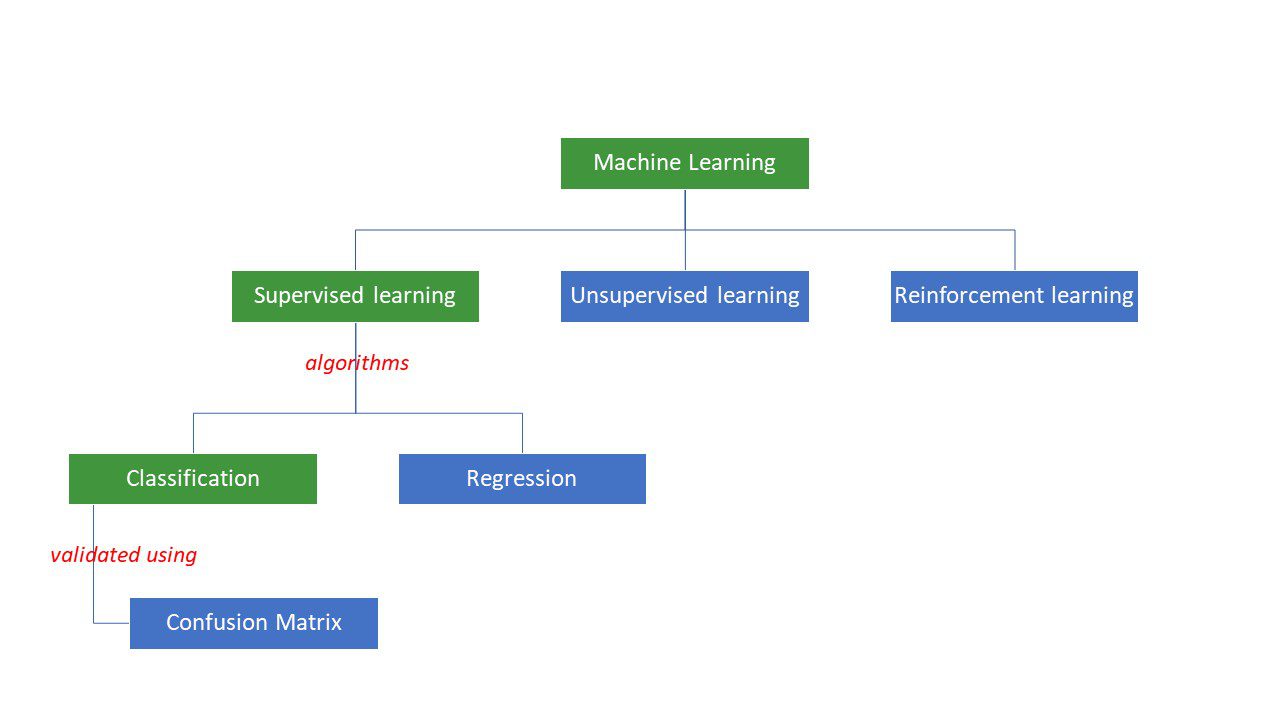

Maschinen versuchen, bestimmte Antworten auf ein Problem zu finden, indem sie eine bestimmte Logik oder einen Satz von Anweisungen anwenden, die als maschinelle Lernalgorithmen bezeichnet werden. Es gibt drei Arten von Algorithmen für maschinelles Lernen – überwacht, nicht überwacht oder verstärkt.

Arten von Algorithmen für maschinelles Lernen

Arten von Algorithmen für maschinelles Lernen

Die einfachsten Arten von Algorithmen werden überwacht, wo wir die Antwort bereits kennen, und wir trainieren die Maschinen, um zu dieser Antwort zu gelangen, indem wir den Algorithmus mit vielen Daten trainieren – genauso wie ein Kind zwischen Menschen verschiedener Altersgruppen unterscheiden würde immer wieder auf ihre Gesichtszüge blicken.

Es gibt zwei Arten von überwachten ML-Algorithmen – Klassifizierung und Regression.

Klassifizierungsalgorithmen klassifizieren oder sortieren Daten basierend auf bestimmten Kriterien. Wenn Sie beispielsweise möchten, dass Ihr Algorithmus Kunden basierend auf ihren Essenspräferenzen gruppiert – diejenigen, die Pizza mögen und diejenigen, die keine Pizza mögen, würden Sie einen Klassifizierungsalgorithmus wie Entscheidungsbaum, Random Forest, Naive Bayes oder SVM (Support Vektormaschine).

Welcher dieser Algorithmen würde die beste Arbeit leisten? Warum sollten Sie einen Algorithmus dem anderen vorziehen?

Geben Sie die Konfusionsmatrix ein….

Eine Konfusionsmatrix ist eine Matrix oder Tabelle, die Informationen darüber gibt, wie genau ein Klassifizierungsalgorithmus bei der Klassifizierung eines Datensatzes ist. Nun, der Name soll die Menschen nicht verwirren, aber zu viele falsche Vorhersagen bedeuten wahrscheinlich, dass der Algorithmus verwirrt war😉!

Eine Konfusionsmatrix ist also eine Methode zur Bewertung der Leistung eines Klassifizierungsalgorithmus.

Wie?

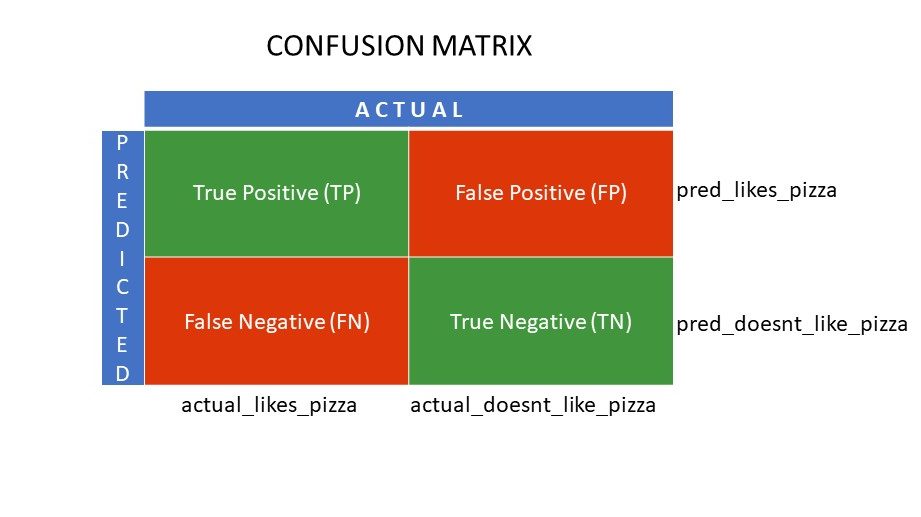

Nehmen wir an, Sie haben verschiedene Algorithmen auf unser zuvor erwähntes binäres Problem angewendet: Klassifizieren (unterteilen) Sie Personen danach, ob sie Pizza mögen oder nicht. Um den Algorithmus auszuwerten, dessen Werte der richtigen Antwort am nächsten kommen, würden Sie eine Konfusionsmatrix verwenden. Für ein binäres Klassifizierungsproblem (Gefällt mir/Gefällt mir nicht, Richtig/Falsch, 1/0) gibt die Konfusionsmatrix vier Gitterwerte, nämlich:

- Richtig positiv (TP)

- Richtig negativ (TN)

- Falsch positiv (FP)

- Falsch negativ (FN)

Was sind die vier Gitter in einer Konfusionsmatrix?

Die vier anhand der Konfusionsmatrix ermittelten Werte bilden die Gitter der Matrix.

Verwirrungsmatrixgitter

Verwirrungsmatrixgitter

True Positive (TP) und True Negative (TN) sind die vom Klassifizierungsalgorithmus korrekt vorhergesagten Werte.

- TP repräsentiert diejenigen, die Pizza mögen, und das Modell hat sie richtig klassifiziert,

- TN repräsentiert diejenigen, die keine Pizza mögen, und das Modell hat sie richtig klassifiziert,

Falsch positiv (FP) und falsch negativ (FN) sind die Werte, die vom Klassifikator falsch vorhergesagt werden.

- FP repräsentiert diejenigen, die keine Pizza mögen (negativ), aber der Klassifikator sagte voraus, dass sie Pizza mögen (fälschlicherweise positiv). FP wird auch als Typ-I-Fehler bezeichnet.

- FN repräsentiert diejenigen, die Pizza mögen (positiv), aber der Klassifikator sagte voraus, dass sie dies nicht tun (fälschlicherweise negativ). FN wird auch als Typ-II-Fehler bezeichnet.

Um das Konzept besser zu verstehen, nehmen wir ein reales Szenario.

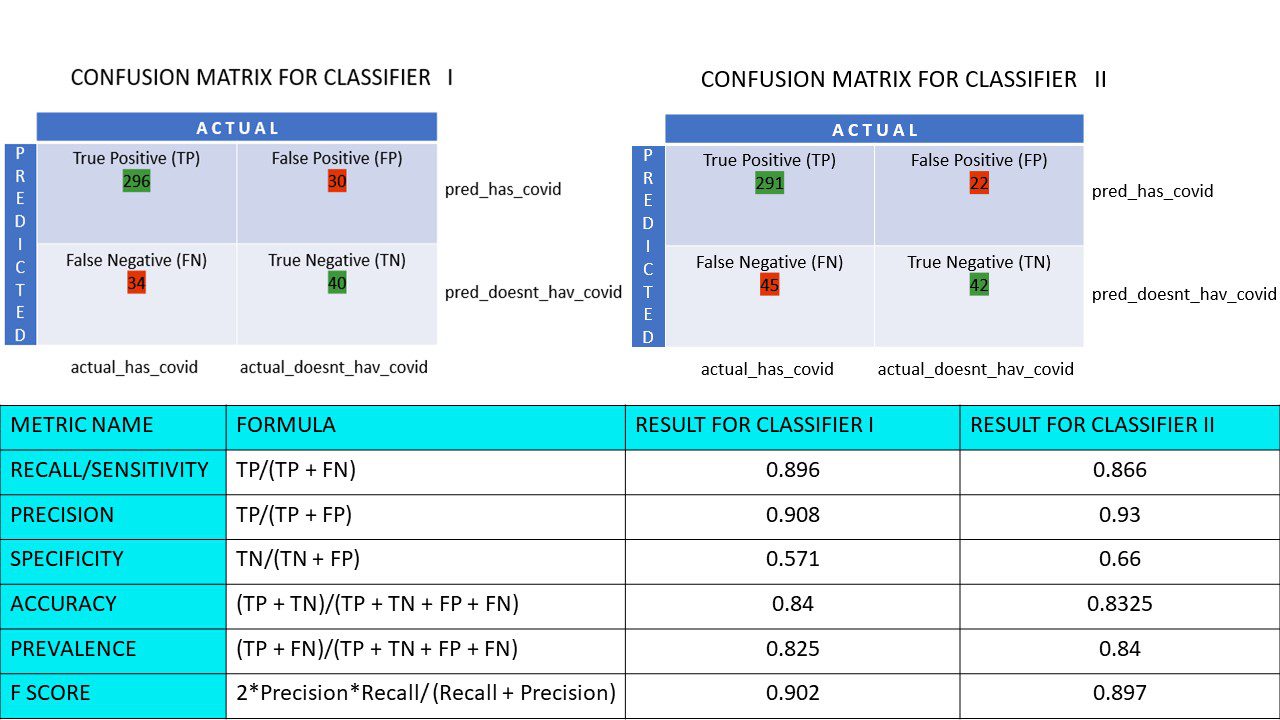

Nehmen wir an, Sie haben einen Datensatz von 400 Personen, die sich dem Covid-Test unterzogen haben. Jetzt haben Sie die Ergebnisse verschiedener Algorithmen erhalten, die die Anzahl der Covid-positiven und Covid-negativen Personen ermittelt haben.

Hier die beiden Konfusionsmatrizen zum Vergleich:

Wenn Sie sich beide ansehen, könnten Sie versucht sein zu sagen, dass der erste Algorithmus genauer ist. Aber um ein konkretes Ergebnis zu erhalten, benötigen wir einige Metriken, die die Genauigkeit, Präzision und viele andere Werte messen können, die beweisen, welcher Algorithmus besser ist.

Metriken mit Konfusionsmatrix und ihre Bedeutung

Die wichtigsten Metriken, die uns bei der Entscheidung helfen, ob der Klassifikator die richtigen Vorhersagen getroffen hat, sind:

#1. Rückruf/Empfindlichkeit

Recall oder Sensitivity oder True Positive Rate (TPR) oder Detection Probability of Detection ist das Verhältnis der korrekten positiven Vorhersagen (TP) zu den gesamten Positiven (dh TP und FN).

R = ZP/(ZP + FN)

Recall ist das Maß der korrekten positiven Ergebnisse, die aus der Anzahl der korrekten positiven Ergebnisse, die hätten produziert werden können, zurückgegeben werden. Ein höherer Recall-Wert bedeutet, dass es weniger falsch negative Ergebnisse gibt, was gut für den Algorithmus ist. Verwenden Sie Recall, wenn es wichtig ist, die falsch negativen Ergebnisse zu kennen. Wenn zum Beispiel eine Person mehrere Blockaden im Herzen hat und das Modell zeigt, dass es ihr absolut gut geht, könnte sich das als tödlich erweisen.

#2. Präzision

Präzision ist das Maß für die korrekten positiven Ergebnisse aus allen vorhergesagten positiven Ergebnissen, einschließlich richtiger und falscher positiver Ergebnisse.

Pr = TP/(TP + FP)

Präzision ist sehr wichtig, wenn die Fehlalarme zu wichtig sind, um ignoriert zu werden. Zum Beispiel, wenn eine Person keinen Diabetes hat, aber das Modell dies anzeigt, und der Arzt bestimmte Medikamente verschreibt. Dies kann zu schweren Nebenwirkungen führen.

#3. Spezifität

Spezifität oder Richtig-Negativ-Rate (TNR) sind korrekte negative Ergebnisse, die aus allen Ergebnissen ermittelt wurden, die negativ hätten sein können.

S = TN/(TN + FP)

Es ist ein Maß dafür, wie gut Ihr Klassifikator die negativen Werte identifiziert.

#4. Genauigkeit

Die Genauigkeit ist die Anzahl der richtigen Vorhersagen aus der Gesamtzahl der Vorhersagen. Wenn Sie also 20 positive und 10 negative Werte aus einer Stichprobe von 50 richtig gefunden haben, beträgt die Genauigkeit Ihres Modells 30/50.

Genauigkeit A = (TP + TN)/(TP + TN + FP + FN)

#5. Häufigkeit

Die Prävalenz ist das Maß für die Anzahl positiver Ergebnisse, die aus allen Ergebnissen erzielt wurden.

P = (TP + FN)/(TP + TN + FP + FN)

#6. F-Punktzahl

Manchmal ist es schwierig, zwei Klassifikatoren (Modelle) nur mit Precision und Recall zu vergleichen, die nur arithmetische Mittel einer Kombination der vier Gitter sind. In solchen Fällen können wir den F-Score oder F1-Score verwenden, das ist das harmonische Mittel – das genauer ist, weil es bei extrem hohen Werten nicht zu stark variiert. Ein höherer F-Score (max. 1) weist auf ein besseres Modell hin.

F-Score = 2*Präzision*Erinnerung/ (Erinnerung + Präzision)

Wenn es wichtig ist, sowohl falsch positive als auch falsch negative Ergebnisse zu berücksichtigen, ist der F1-Score eine gute Metrik. Zum Beispiel müssen diejenigen, die nicht Covid-positiv sind (aber der Algorithmus hat es gezeigt), nicht unnötig isoliert werden. Auf die gleiche Weise müssen diejenigen, die Covid-positiv sind (aber der Algorithmus sagte, dass sie es nicht sind), isoliert werden.

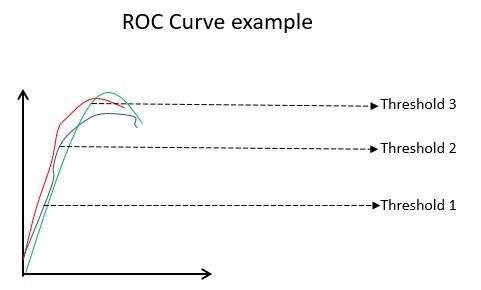

#7. ROC-Kurven

Parameter wie Genauigkeit und Präzision sind gute Metriken, wenn die Daten ausgewogen sind. Bei einem unausgeglichenen Datensatz bedeutet eine hohe Genauigkeit nicht unbedingt, dass der Klassifikator effizient ist. Beispielsweise sprechen 90 von 100 Schülern in einem Kurs Spanisch. Nun, selbst wenn Ihr Algorithmus sagt, dass alle 100 Spanisch können, wird seine Genauigkeit 90 % betragen, was ein falsches Bild über das Modell vermitteln kann. Bei unausgewogenen Datensätzen sind Metriken wie ROC effektivere Bestimmungsfaktoren.

Beispiel einer ROC-Kurve

Beispiel einer ROC-Kurve

Die ROC-Kurve (Receiver Operating Characteristic) zeigt visuell die Leistung eines binären Klassifizierungsmodells bei verschiedenen Klassifizierungsschwellenwerten an. Es ist ein Diagramm von TPR (Wahr-Positiv-Rate) gegen FPR (Falsch-Positiv-Rate), das als (1-Spezifität) bei verschiedenen Schwellenwerten berechnet wird. Der Wert, der im Diagramm 45 Grad am nächsten kommt (oben links), ist der genaueste Schwellenwert. Wenn der Schwellenwert zu hoch ist, werden wir nicht viele falsch positive Ergebnisse haben, aber wir werden mehr falsch negative Ergebnisse erhalten und umgekehrt.

Wenn die ROC-Kurve für verschiedene Modelle aufgetragen wird, wird im Allgemeinen dasjenige mit der größten Fläche unter der Kurve (AUC) als das bessere Modell angesehen.

Lassen Sie uns alle Metrikwerte für unsere Klassifikator-I- und Klassifikator-II-Verwirrungsmatrizen berechnen:

Metrikvergleich für die Klassifikatoren 1 und 2 der Pizza-Umfrage

Metrikvergleich für die Klassifikatoren 1 und 2 der Pizza-Umfrage

Wir sehen, dass die Genauigkeit beim Klassifikator II höher ist, während die Genauigkeit beim Klassifikator I etwas höher ist. Je nach Problemstellung können Entscheidungsträger Klassifikator I oder II auswählen.

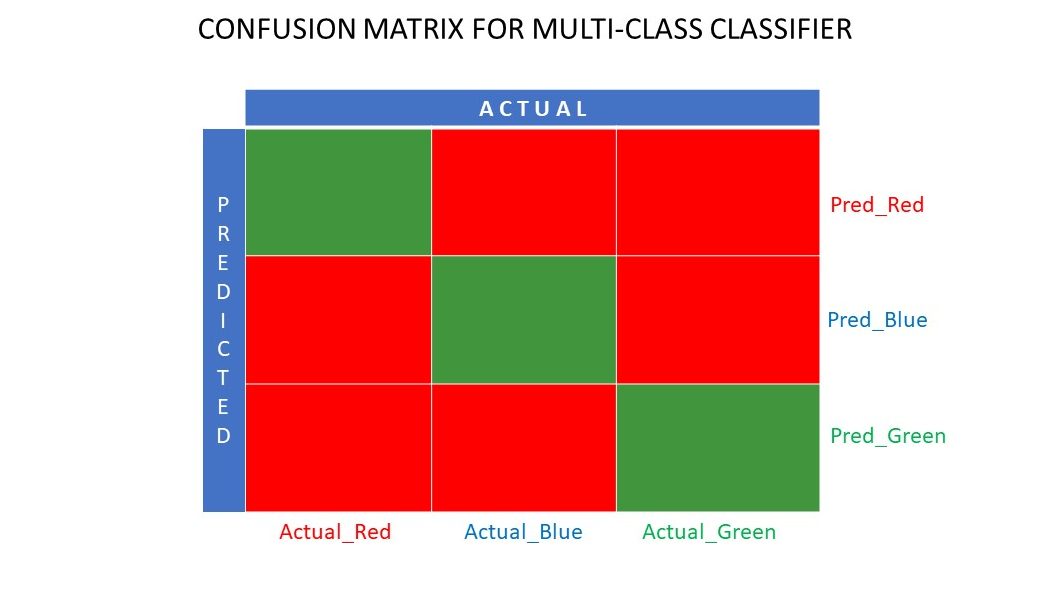

N x N Konfusionsmatrix

Bisher haben wir eine Konfusionsmatrix für binäre Klassifikatoren gesehen. Was wäre, wenn es mehr Kategorien gäbe als nur ja/nein oder mögen/nicht mögen. Zum Beispiel, wenn Ihr Algorithmus Bilder in den Farben Rot, Grün und Blau sortieren sollte. Diese Art der Klassifizierung wird als Mehrklassenklassifizierung bezeichnet. Die Anzahl der Ausgangsvariablen entscheidet auch über die Größe der Matrix. In diesem Fall ist die Verwirrungsmatrix also 3 × 3.

Konfusionsmatrix für einen Klassifikator mit mehreren Klassen

Konfusionsmatrix für einen Klassifikator mit mehreren Klassen

Zusammenfassung

Eine Konfusionsmatrix ist ein großartiges Bewertungssystem, da sie detaillierte Informationen über die Leistung eines Klassifizierungsalgorithmus liefert. Es funktioniert gut für binäre sowie mehrklassige Klassifikatoren, bei denen mehr als 2 Parameter zu beachten sind. Es ist einfach, eine Konfusionsmatrix zu visualisieren, und wir können alle anderen Leistungsmetriken wie F-Score, Präzision, ROC und Genauigkeit mithilfe der Konfusionsmatrix generieren.

Sie können sich auch ansehen, wie Sie ML-Algorithmen für Regressionsprobleme auswählen.